11 ژانویه 2021توسط انجمن ماکس پلانک

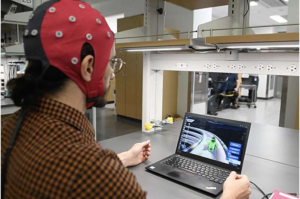

وقف هوش مصنوعی با اهداف عالیه ممکن است از عواقب ناخواسته جلوگیری کند. اعتبار: ایاد رهوان

ما شیفته ماشین هایی هستیم که می توانند ماشین ها را کنترل کنند ، سمفونی بسازند یا مردم را در شطرنج ، Go یا Jeopardy شکست دهند! در حالی که بصورت دایمی در هوش مصنوعی (AI) پیشرفت بیشتری حاصل می شود ، برخی از دانشمندان و فلاسفه درباره خطرات هوش مصنوعی فوق العاده ، غیرقابل کنترل هشدار می دهند. با استفاده از محاسبات نظری ، یک تیم بین المللی از محققان ، از جمله دانشمندان مرکز انسان ها و ماشین آلات در موسسه توسعه انسانی ماکس پلانک ، نشان می دهد که کنترل هوش مصنوعی فوق هوشمند امکان پذیر نیست.

فرض کنید کسی بخواهد یک سیستم AI را با هوش برتر از انسان برنامه ریزی کند ، بنابراین این ماشین می تواند به طور مستقل یاد بگیرد. متصل به اینترنت ، هوش مصنوعی ممکن است به تمام داده های بشریت دسترسی داشته باشد. این انر می تواند جایگزین تمام برنامه های موجود شود و کلیه ماشین آلات آنلاین را در سراسر جهان کنترل کند. آیا این یک مدینه فاضله یا دیستوپی خواهد بود؟ آیا AI می تواند سرطان را درمان کند ، صلح جهانی ایجاد کند و از یک فاجعه آب و هوایی جلوگیری کند؟ یا این باعث نابودی بشریت و تصرف زمین خواهد شد؟

دانشمندان و فیلسوفان کامپیوتر از خود پرسیده اند که آیا حتی قادر به کنترل هوش مصنوعی فوق العاده هوشمند هستیم تا اطمینان حاصل شود که خطری برای بشریت به وجود نمی آورد. یک تیم بین المللی از دانشمندان کامپیوتر با استفاده از محاسبات نظری نشان دادند که کنترل یک هوش مصنوعی فوق العاده هوشمند کاملاً غیرممکن است

مانوئل سبرین ، همکار نویسنده تحقیق ، رهبر گروه بسیج دیجیتال در مرکز انسانها و ماشین آلات ، موسسه توسعه انسانی ماکس پلانک می گوید که :

“یک ماشین فوق العاده هوشمند که جهان را کنترل می کند مانند داستان های علمی تخیلی به نظر می رسد. اما در حال حاضر ماشین هایی وجود دارند که برخی از کارهای مهم را به طور مستقل انجام می دهند بدون اینکه برنامه نویسان کاملاً یاد بگیرند که چگونه آن را یاد گرفته اند. بنابراین این سوال مطرح می شود که آیا این امر در برخی مواقع غیرقابل کنترل و برای انسان خطرناک است “.

دانشمندان دو ایده مختلف را برای چگونگی کنترل هوش مصنوعی فوق العاده هوشمند جستجو کرده اند. از یک طرف ، توانایی هوش مصنوعی فوق العاده هوشمند می تواند به طور خاص محدود شود ، به عنوان مثال ، با جدا کردن آن از اینترنت و همه دستگاه های فنی دیگر ، بنابراین نمی تواند هیچ ارتباطی با دنیای خارج داشته باشد – در این حالت ، هوش مصنوعی فوق هوشمند به طور قابل توجهی کمتر است ، کمتر توانایی پاسخگویی به تلاشهای علوم انسانی را دارد. فقط این گزینه ، هوش مصنوعی از همان ابتدا می تواند انگیزه داشته باشد که فقط اهدافی را دنبال کند که به نفع بشریت باشد ، به عنوان مثال با برنامه ریزی اصول اخلاقی در آن. با این حال ، محققان همچنین نشان می دهند که این ایده ها و سایر ایده های معاصر و تاریخی برای کنترل هوش مصنوعی فوق العاده ، دارای محدودیت هایی هستند.

این تیم یک الگوریتم مهار نظری را ابداع کرد که اطمینان حاصل کند هوش مصنوعی فوق العاده هوشمند تحت هیچ شرایطی نمی تواند به مردم آسیب برساند ، ابتدا با شبیه سازی رفتار AI و در صورت مضر دانستن آن را متوقف می کند. اما تحلیل دقیق نشان می دهد که در الگوی محاسبات فعلی ما ، چنین الگوریتمی قابل ساخت نیست.

“اگر این مسئله را به قوانین اساسی علوم رایانه نظری تقسیم کنید ، معلوم می شود که الگوریتمی که به یک هوش مصنوعی دستور می دهد جهان را از بین نبرد ، می تواند ناخواسته عملیات خود را متوقف کند. اگر این اتفاق می افتاد ، نمی دانید که الگوریتم مهارشده یا نه . ایاد رهوان ، مدیر مرکز انسانها و ماشین ها ، می گوید: “هنوز تهدید را تجزیه و تحلیل می کند ، یا اینکه آیا آن را مهار کرده است و آیا AI را مضر نگه نمی دارد. در واقع ، این باعث می شود الگوریتم مهار شده غیرقابل استفاده شود.”

بر اساس این محاسبات ، مسئله مهار غیرقابل انکار است ، به عنوان مثال هیچ الگوریتمی نمی تواند راه حلی برای تعیین اینکه آیا هوش مصنوعی به دنیا آسیب می رساند پیدا کند. بعلاوه ، محققان نشان دادند که ما حتی نمی توانیم از زمان ورود ماشینهای فوق هوشمند مطلع باشیم ، زیرا تصمیم گیری در مورد اینکه آیا یک ماشین هوش برتر ، یک ماشین را نشان می دهد که در همان قلمرو مشکل مهارقرار دارد یا نه .