توسط پیتر گراد، Tech Xplore

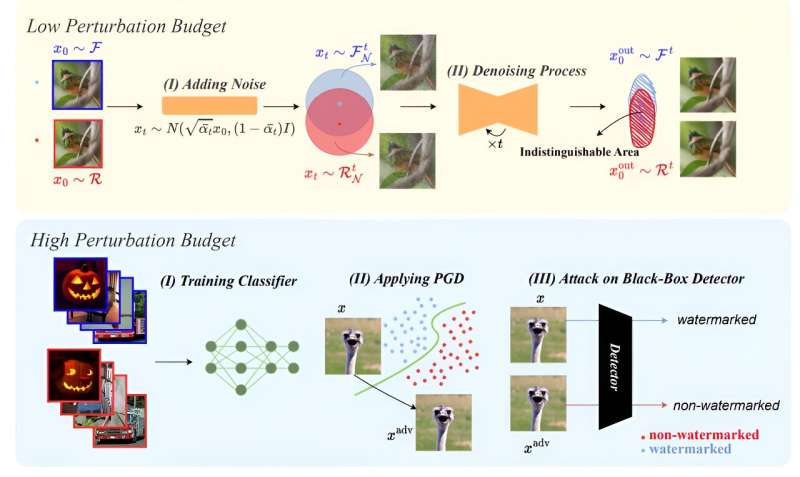

تصویری از حملات ما علیه روش های واترمارک تصویر. پانل بالایی حمله تصفیه انتشار را برای واترمارک های کم هزینه اغتشاش (غیر محسوس) نشان می دهد. نویز گاوسی را به تصاویر اضافه می کند و یک ناحیه غیر قابل تشخیص ایجاد می کند که منجر به یک کران پایین تایید شده در خطای آشکارسازهای واترمارک می شود. سپس تصاویر نویزدار با استفاده از مدلهای انتشار دینویز میشوند. پانل پایینی حمله خصمانه جایگزین مدل ما را در برابر واترمارک های بودجه با اغتشاش بالا نشان می دهد. حمله ما شامل آموزش یک طبقهبندی کننده جایگزین، انجام یک حمله PGD بر روی مدل جایگزین و استفاده از این تصاویر دستکاری شده برای فریب آشکارساز علامت جعبه سیاه است. اعتبار: arXiv (2023). DOI:

شاید ترسناک ترین جنبه هوش مصنوعی ظرفیت آن برای تولید تصاویر دیپ فیک باشد.

مطمئناً برخی از این تصاویر باعث خنده می شوند. قرار دادن صورت آرنولد شوارتزنگر روی هری کثیف کلینت ایستوود که اسلحه را به سمت مظنون فراری نشانه رفته است. تغییر شکل مایک تایسون به اپرا. تبدیل کردن دونالد ترامپ به باب اودنکرک در فیلم «بهتر است با سال تماس بگیری». نیکلاس کیج در نقش لوئیز لین در فیلم «سوپرمن».

اما با مخرب تر شدن جعل دیجیتال، تحولات اخیر روند نگرانکنندهتری را نشان میدهد.

همین هفته گذشته، تام هنکس بازیگر مشهور در رسانه های اجتماعی آگهی تبلیغاتی را که از تصویری تولید شده توسط هوش مصنوعی از او برای ترویج یک برنامه بهداشت دندان استفاده می کرد محکوم کرد. کاربر محبوب یوتیوب مستر بیست که ویدیوهای او از سال 2012 تاکنون بیش از 50 میلیارد بازدید کرده داشته اند به دروغ نشان داده شد که آیفون 15 پرو را به قیمت 2 دلار ارائه می دهد.

و با نزدیک شدن ایالات متحده دچار به شکاف سیاسی با احتیاط به رقابت های ریاست جمهوری بسیار بحث برانگیز در سال 2024 نزدیک می شود، احتمال تصاویر و ویدئوهای جعلی نوید یک انتخابات با زشتی بی سابقه را می دهد.

علاوه بر این، اشاعه تصاویر جعلی می تواند سیستم حقوقی را که ما می شناسیم، را ریشه کن کند. بر اساس گزارش اخیر رسانه ملی غیرانتفاعی NPR ، وکلا بر روی مردم بیچاره که گاهی اوقات در مورد درست یا نادرست بودن ادعایی گیج شده اند، سرمایه گذاری می کنند و شواهد ارائه شده در دادگاه را به طور فزاینده ای به چالش می کشند.

هانی فرید، متخصص در تجزیه و تحلیل تصاویر دیجیتال در دانشگاه کالیفرنیا، برکلی، گفت: “این دقیقاً همان چیزی است که ما نگران آن بودیم، اینکه با ورود به این عصر دیپ فیک، هر کسی می تواند واقعیت را انکار کند.”

او با اشاره به اصطلاحی که اولین بار در سال 2018 در گزارشی درباره احتمال نقض حریم خصوصی و دموکراسی با استفاده از دیپ فیک استفاده شد، گفت: «این همان سود سهام دروغگوی قدیمی است.»

شرکتهای بزرگ رسانههای دیجیتال – OpenAI، Alphabet، Amazon، DeepMind- قول دادهاند که ابزارهایی برای مبارزه با دروغ پراکنی توسعه دهند. یکی از رویکردهای کلیدی استفاده از واترمارک در محتوای تولید شده توسط هوش مصنوعی است.

اما مقالهای که در 29 سپتامبر در سرور پیشچاپ arXiv منتشر شد، اخبار نگرانکنندهای را در مورد امکان دیپ فیک محدود کردن چنین سوءاستفادههای دیجیتالی منتشر میکند.

استادان دانشگاه مریلند آزمایشهایی را انجام دادند که روش های آسان دور زدن واترمارکهای محافظ را نشان می داد.

سهیل فیضی، یکی از نویسندگان گزارش با عنوان «استحکام آشکارسازهای Ai-Image: محدودیت های بنیادین و حملات عملی» گفت: «در حال حاضر هیچ روش واترمارکینگ قابل اعتمادی در اختیار نداریم.

فیضی گفت که تیمش “همه آنها را شکست.”

فیضی هشدار داد: «استفاده نادرست از هوش مصنوعی خطرات بالقوه مرتبط با انتشار اطلاعات غلط، کلاهبرداری و حتی مسائل امنیت ملی مانند دستکاری در انتخابات را به همراه دارد. «دیپفیکها میتوانند منجر به آسیبهای شخصی، از تهمت به شخصیت ها تا پریشانی عاطفی شوند، که بر افراد و نیز جامعه تأثیر میگذارد. در نتیجه، شناسایی محتوای تولید شده توسط هوش مصنوعی… چالشی حیاتی در حال ظهور است».

این تیم از فرآیندی به نام تصفیه انتشار استفاده کردند که نویز گاوسی را به واترمارک اعمال میکند و سپس آن را حذف میکند. این عمل یک واترمارک مخدوش باقی می گذارد که می تواند الگوریتم های تشخیص را دور بزند. بقیه تصویر فقط اندکی تغییر یافته است.

آنها همچنین با موفقیت نشان دادند که بازیگران بی اخلاق که به الگوریتمهای واترمارک جعبه سیاه دسترسی دارند، میتوانند عکسهای جعلی را با علامتهایی که آشکارسازها را فریب میدهند، جا بزنند.

مطمئنا الگوریتم های بهتری به وجود خواهند آمد. همانطور که در مورد حملات ویروسی رخ داده است، افراد بد همیشه در تلاش هستند تا هر دفاعی را که افراد خوب ارائه می دهند، بشکنند و بازی موش و گربه ادامه خواهد داشت.

اما فیضی کمی ابراز خوش بینی کرد.

او گفت: «بر اساس نتایج ما، طراحی یک واترمارک قوی یک کار چالش برانگیز، اما لزوما غیرممکن نیست.

در حال حاضر، افراد باید هنگام بررسی تصاویر حاوی محتوایی که ممکن است برایشان مهم باشد، دقت لازم را انجام دهند. هوشیاری، بررسی مجدد منابع و میزان کافی عقل سلیم لازم است.