10 فوریه 2021 توسط دانیل آکرمن ، انستیتوی فناوری ماساچوست

محققان MIT یک سیستم سخت افزاری و نرم افزاری ایجاد کردند که می تواند قدرت ، انرژی و زمان محاسباتی مورد نیاز برای تجزیه و تحلیل متن و تولید را کاهش دهد.

زبان انسان می تواند ناکارآمد باشد. برخی از کلمات برای دیگران حیاطی و قابل مصرف است.

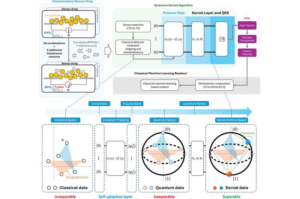

جمله اول را دوباره بخوانید. فقط دو کلمه “زبان” و “ناکارآمد” تقریباً معنی کل جمله را منتقل می کنند. اهمیت کلمات کلیدی زمینه ساز یک ابزار جدید محبوب برای پردازش زبان طبیعی (NLP) توسط رایانه ها است: مکانیسم توجه هنگامی که در الگوریتم NLP گسترده تری رمزگذاری می شود ، مکانیزم توجه کلمات کلیدی را در خود جای می دهد تا اینکه هر کلمه را با همان اهمیت درک کند. این امر نتایج بهتری در کارهای NLP مانند تشخیص احساسات مثبت یا منفی یا پیش بینی کلمات بعدی در جمله را به دست می دهد.

دقت مکانیزم توجه ، اغلب به هزینه سرعت و قدرت محاسبه می انجامد. ولی به آرامی روی پردازنده های عمومی کاربردی مانند آنچه در رایانه های مصرف کننده پیدا می کنید ، کار می کند. بنابراین ، محققان MIT یک سیستم نرم افزاری-سخت افزاری را با نام SpAtten طراحی کرده اند که به طور تخصصی برای اجرای مکانیسم توجه طراحی شده است

هانروی وانگ می گوید: “سیستم ما شبیه نحوه پردازش زبان توسط مغز انسان است.” “ما خیلی سریع می خوانیم و فقط روی کلمات کلیدی تمرکز می کنیم. این ایده با SpAtten است.”

از زمان معرفی آن در سال 2015 ، سازوکار توجه برای NLP یک مزیت بوده است. این مدل در پیشرفته ترین مدل های NLP مانند BERT گوگل و GPT-3 OpenAI ساخته شده است. نوآوری اصلی سازوکار توجه ، انتخاب است که می تواند بر اساس مقایسه با الگوهای کلمه ای که الگوریتم قبلاً در یک مرحله آموزش با آن روبرو بوده است ، مهمترین کلمات یا عبارات را در یک جمله استنباط کند. با وجود استفاده سریع از مکانیزم توجه به مدل های NLP ، این کار بدون هزینه نیست.

مدل های NLP به دلیل کمبود حافظه در مکانیزم توجه ، به یک مقدار زیاد کامپیوتر نیاز دارند. وانگ می گوید: “این قسمت در واقع گلوگاه مدل های NLP است.” یکی از چالش هایی که وی به آن اشاره کرد ، کمبود سخت افزار تخصصی برای اجرای مدل های NLP با مکانیزم توجه است. پردازنده های عمومی ، مانند پردازنده ها و پردازنده های گرافیکی ، در توالی پیچیده حرکت داده ها و حساب مکانیسم توجه مشکل دارند. با پیچیدگی بیشتر مدل های NLP ، به ویژه برای جملات طولانی ، این مشکل بدتر خواهد شد. وانگ می گوید: “ما برای پردازش تقاضای محاسباتی روزافزون به بهینه سازی الگوریتمی و سخت افزار اختصاصی نیاز داریم.”

برای اصلاح بیشتر استفاده از حافظه ، محققان همچنین تکنیکی را به نام “کوانته سازی تدریجی” ایجاد کردند. این روش به الگوریتم اجازه می دهد تا داده ها را در تکه های کویت کوچکتر بدست آورد و تا آنجا که ممکن است از حافظه واکشی کند. برای جملات ساده از دقت پایین تر داده ، متناظر با پهنای بیت کوچکتر ، و برای جملات پیچیده ، از دقت بالاتر استفاده می شود.