29 نوامبر 2024 – توسط Ingrid Fadelli، Tech Xploreاعتبار: arXiv (2024). DOI:

یکی از امیدوارکنندهترین رویکردها برای آموزش روباتها برای انجام کارهای دستی مانند تمیز کردن ظروف یا تهیه غذا، یادگیری تقلید است. یادگیری تقلید انتها به انتها معمولاً مستلزم آموزش یک الگوریتم یادگیری عمیق بر روی ویدئوهای خام، تصاویر و/یا دادههای ضبط حرکت انسانهایی است که کارهای دستی را انجام میدهند.

در طول این آموزش، الگوریتم به تدریج یاد می گیرد که اقدامات خروجی (یعنی حرکات مفصل ربات، مسیرها، و غیره) تولید کند که به یک ربات اجازه می دهد تا وظایف مشابه را با موفقیت انجام دهد.

در حالی که تکنیکهای یادگیری تقلید میتوانند توانایی رباتها را برای تکمیل وظایف پیچیده دستکاری اشیا افزایش دهند، آنها اغلب به روباتها اجازه تعمیم وظایفی که در مجموعه داده آموزشی گنجانده نشدهاند را نمیدهند. علاوه بر این، جمع آوری نمایش های آموزشی برای طیف گسترده ای از وظایف می تواند چالش برانگیز باشد و به حسگرها یا تجهیزات پیشرفته نیاز دارد.

محققان موسسه فناوری جورجیا اخیرا EgoMimic را معرفی کردهاند، چارچوب جدیدی که میتواند برای جمعآوری آسان دادههای نمایشی متنوعتر برای یادگیری تقلید استفاده شود. این چارچوب، که در مقاله ارسال شده به سرور preprint arXiv معرفی شده است، یک پلتفرم مقیاسپذیر برای جمعآوری نمایشهای ویدئویی از انسانهایی که وظایف دستی را انجام میدهند، از نقطه نظر فردی که کار را انجام میدهد (یعنی خود محور) ارائه میدهد.

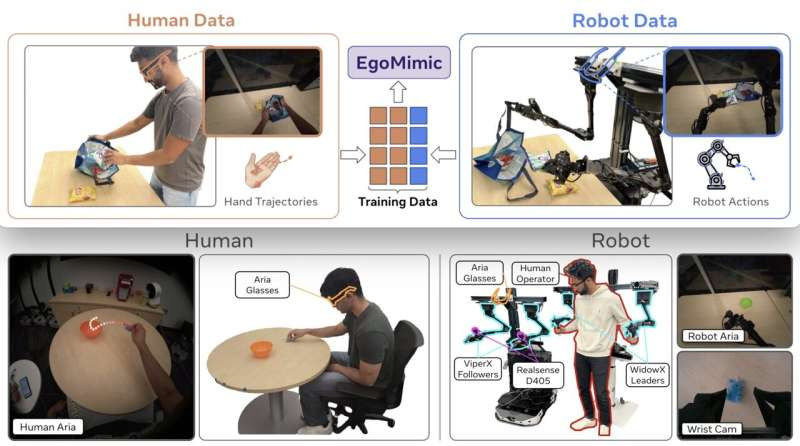

Simar Kareer، Dhruv Patel و همکارانشان در مقاله خود نوشتند: «ما EgoMimic، یک چارچوب تمام پشته را ارائه میکنیم که دستکاری را از طریق دادههای تجسم انسانی، بهویژه ویدیوهای انسان خودمحور همراه با ردیابی دست سهبعدی، مقیاسبندی میکند».

EgoMimic از طریق: (1) سیستمی برای گرفتن داده های تجسم انسانی با استفاده از عینک های ارگونومیک Project Aria، (2) یک دستکاری کننده دو دستی ارزان قیمت که شکاف سینماتیکی را با داده های انسانی به حداقل می رساند، (3) تکنیک های هم ترازی داده های متقابل دامنه را به دست می آورد. و (4) معماری یادگیری تقلیدی که بر روی دادههای انسان و ربات آموزش میدهد.”

اولین مؤلفه چارچوب EgoMimic، سیستمی برای ضبط ویدیوهای نمایشی، بر استفاده از Project Aria، عینک هوشمند پوشیدنی که در Meta Reality Labs Research ایجاد شده است، متکی است. این عینک توسط انسان ها در هنگام انجام کارهای دستی روزمره استفاده می شود تا کار را از دید خود ثبت کند.

سیستم رباتیک دو دستی که محققان برای مقابله با وظایف مشابه انجام شده توسط انسان استفاده کردند، شامل دو بازوی روباتیک Viper X است که دوربینهای مچ RealSense اینتل را ادغام میکند که به نوبه خود توسط دو بازوی روباتیک WidowX کنترل میشوند. نکته قابل توجه این است که این ربات دو دستی همچنین هنگام انجام یک کار از عینک آریا استفاده می کند، زیرا این تفاوت بین فیلم نمایشگرهای انسانی در حال انجام وظایف و دید ربات از فضای کار را به حداقل می رساند.

Kareer، Patel و همکارانشان نوشتند: «در مقایسه با کارهای قبلی که فقط اهداف سطح بالا را از ویدیوهای انسانی استخراج میکنند، رویکرد ما با دادههای انسان و روبات بهطور مساوی به عنوان دادههای نمایشی تجسم یافته رفتار میکند و یک خط مشی واحد را از هر دو منبع داده میآموزد».

محققان چارچوب پیشنهادی خود را با اجرای مجموعهای از آزمایشها در آزمایشگاه خود آزمایش کردند، جایی که ربات آنها یاد گرفت وظایف دنیای واقعی را با افق بلند تکمیل کند. به عنوان مثال، ربات یاد گرفت که یک اسباب بازی کوچک مخمل خواب دار را بردارد، آن را در یک کاسه بگذارد، کاسه را بردارید و اسباب بازی را روی میز بیندازید و سپس این ترتیب حرکات را برای 40 ثانیه تکرار کنید.

از دیگر کارهایی که در آن آموزش دیده بود، تا کردن تیشرتها به شیوهای خاص و پر کردن کیسههای مواد غذایی با کیسههای چیپس بود. نتایج این آزمایشهای اولیه بسیار امیدوارکننده بود، زیرا چارچوب EgoMimic عملکرد بهتری را در این سه کار نسبت به سایر تکنیکهای پیشرفتهی یادگیری تقلیدی که در گذشته معرفی شده بود، داشت، در حالی که به ربات اجازه میداد تا مهارتهایی را که آموخته بود بهطور مؤثر به کار گیرد. به وظایفی که در طول آموزش با آنها مواجه نشده بود.

Kareer، Patel و همکارانشان نوشتند: EgoMimic در مجموعه متنوعی از کارهای دستکاری افق بلند، تک بازویی و دو دستی نسبت به روشهای یادگیری تقلیدی پیشرفته به پیشرفت قابل توجهی دست مییابد و تعمیم به صحنههای کاملاً جدید را امکانپذیر میسازد». در نهایت، ما یک روند مقیاسپذیری مطلوب را برای EgoMimic نشان میدهیم، که در آن افزودن ۱ ساعت اطلاعات دستی اضافی بهطور قابلتوجهی از ۱ ساعت دادههای اضافی ربات ارزشمندتر است.

کد پردازش داده ها و مدل های آموزشی مورد استفاده محققان در GitHub موجود است. در آینده، EgoMimic یا اقتباسهایی از آن میتواند توسط دیگر روباتیکها در سرتاسر جهان برای بهبود عملکرد و تعمیمپذیری سیستمهای روباتیک مختلف در کارهای مختلف روزمره که شامل دستکاری اشیاء است، استفاده شود.