24 آگوست 2020توسط تام بارات ، الکس وین

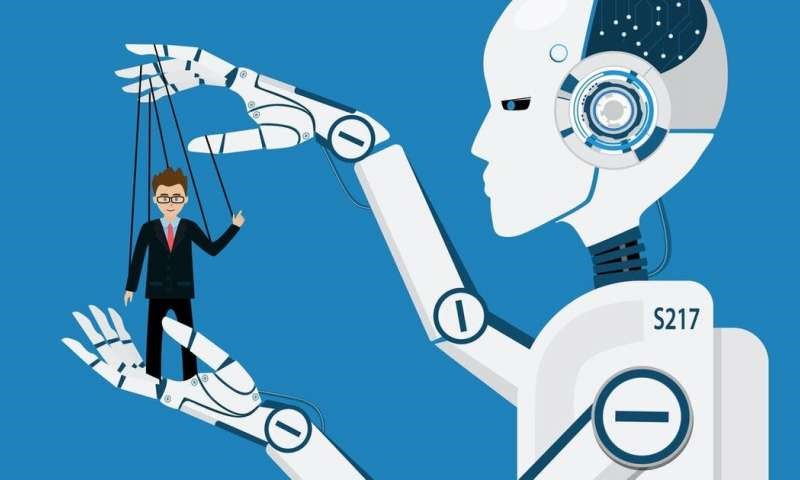

در فیلم ها ی سینمایی همنند ادیسه فضایی نشان داده شده است که ، هنگامی که یک ماشین تصمیم می گیرد رئیس باشد – یا انسان این اجازه را می دهد – همه چیز اشتباه می شود. با وجود این هشدارهای بی نظیر وپیایی ، کنترل امور توسط ماشین آلات به سرعت در حال تبدیل شدن به واقعیتی برای ما است.

الگوریتم ها — مجموعه دستورالعمل ها برای حل یک مشکل یا انجام یک کار — اکنون همه چیز را از نتایج جستجوی مرورگر تا مراقبت های پزشکی را بهتر هدایت می کنند.

آنها به طراحی ساختمانها کمک می کنند. آنها در حال سرعت بخشیدن به تجارت در بازارهای مالی هستند و گاه ثروت خود را در عرض چند ثانیه از دست می دهند. آنها در حال محاسبه کارآمدترین مسیرها برای رانندگان تحویل دهنده کالا ها هستند.

در محل کار ، سیستم های رایانه ای الگوریتمی خودآموز توسط شرکت ها معرفی می شوند تا در زمینه هایی از جمله استخدام ، تعیین وظایف ، اندازه گیری بهره وری ، ارزیابی عملکرد و حتی خاتمه دادن به اشتغال در شرکت تصمیم گیری کنند: “متأسفم ، دیو می ترسم بگویم که شما از کار برکنار شده اید.

به الگوریتم های خودآموز در خصوص مسئولیت تصمیم گیری و اجرای تصمیمات مؤثر بر کارکنان ، “مدیریت الگوریتمی” گفته می شود. این سیستم خطرات زیادی را در سیستم های مدیریت شخصی و وارد کردن خسارات نسبت به قبل را ایجاد می کند.

شاید در یک سطح حتی عمیق تر ، مدیریت الگوریتمی عدم تعادل قدرت بین مدیریت و کارکنان را افزایش دهد. الگوریتم ها از درک اسرار عاجزند. فرآیندهای تصمیم گیری آنها پنهان است. این یک جعبه سیاه است: شاید شما از داده هایی که وارد شده است و نتیجه ای را می بینید که بیرون می آید ، کمی درک داشته باشید اما شما هیچ تصوری از آنچه در میان است نمی دانید.

دروس گسترده تر

هنگامی که مدیریت الگوریتمی به عنوان “جعبه سیاه” عمل می کند یکی از پیامدهای آن این است که می تواند به یک مکانیسم کنترل غیرمستقیم تبدیل شود. این مکانیسم کنترل تا کنون مورد استقبال تنظیم کنندگان استرالیا قرار گرفته است و این امکان را فراهم می آورد تا ضمن اجتناب از مسئولیت های کارفرما ، یک نیروی کار مطمئن و مقیاس پذیر را نیز تجهیز کند. تحقیق دولت ویکتوریا در مورد یادداشتهای نیروی کار می گوید که :

“عدم وجود شواهد مشخص در مورد نحوه عملکرد الگوریتمها” ،”باعث می شود که راننده یا مسافر در صورت احساس ناتوانی از طرف یکی از آنها ، شکایت کند.”

در این گزارش ، که در ماه ژوئن منتشر شد ، نیز آمده است: تأیید صحت نگرانی در مورد شفافیت الگوریتم دشوار است.اما این یک واقعیت است که تأیید این مشکل دشوار است. چگونه می توانیم مسائلی مانند مدیریت الگوریتمی را حتی شناسایی کنیم ، چه رسد به حل کردن آن؟

استانداردهای رفتار منصفانه برای اطمینان از شفافیت و پاسخگویی یک شروع برای این کاراست. یک مثال ابتکار عملی Fair است که توسط موسسه اینترنتی آکسفورد رهبری می شود. این عمل ابتکاری محققان را با سیستم عامل ها ، کارکنانان ، اتحادیه ها و تنظیم کننده ها گرد هم آورده است تا اصول جهانی را برای کار در اقتصاد پلتفرمی توسعه دهند. این شامل موضوع “مدیریت منصفانه” است که بر چگونگی شفافیت نتایج الگوریتم بر روی کارکنانان متمرکز است.

درک ما در مورد تأثیر الگوریتمها بر همه اشکال کار هنوز در مراحل ابتدایی است. این امر نیاز به بررسی و تحقیق بیشتری دارد. بدون نظارت انسانی براساس اصول توافق شده ، تحمل خطر ورود این الگوریتم ها به محل کار خود را نداریم.

https://techxplore.com