16 ژوئیه سال 2020توسط Ruhr-Universitaet-Bochum

تصاویر به اصطلاح جعلی با الگوریتم های یادگیری ماشینی تولید می شوند و انسان ها تقریباً قادر به تشخیص آنها از عکس های واقعی نیستند آنها به طرز فریبنده ای واقعی به نظر می رسند ، اما توسط رایانه ها ساخته شده اند . محققان موسسه امنیت فناوری اطلاعات Horst Görtz در Ruhr-Universität Bochum و خوشه تعالی “امنیت سایبری ” (Casa) روش جدیدی را برای شناسایی کارآمد تصاویر عمیقا جعلی ایجاد کرده اند. برای این منظور ، آنها اشیاء موجود در مقابل فرکانس را ، با یک تکنیک پردازش سیگنال تجزیه و تحلیل می کنند.

این تیم کار خود را در کنفرانس بین المللی یادگیری ماشین ، یکی از کنفرانس های پیشرو در زمینه یادگیری ماشین (ICML) در تاریخ 15 ژوئیه 2020 ارائه دادند ،. علاوه بر این ، محققان کد خود را بصورت آنلاین در دسترس قرار می دهند تا گروه های دیگر بتوانند نتایج خود را بازتولید کنند.

تعامل دو الگوریتم منجر به تصاویر جدید می شود.

تصاویر عمیقا جعلی – یک کلمه منشعب از “یادگیری عمیق” برای یادگیری ماشین و “جعلی” – که با کمک مدل های رایانه ای ، به اصطلاح شبکه های تبلیغاتی مولد ، به طور خلاصه تولید می شود ، انتخاب شده است . دو الگوریتم در این شبکه ها با هم کار می کنند: الگوریتم اول تصاویر تصادفی را بر اساس داده های ورودی خاص ایجاد می کند. الگوریتم دوم باید تصمیم بگیرد که آیا این تصویر جعلی است یا نه. اگر تصور شود جعلی است ، الگوریتم دوم دستور تجدید نظر در تصویر را به الگوریتم اول می دهد – تا زمانی که دیگر آن را جعلی تشخیص ندهد.

در سال های اخیر ، این تکنیک به تشعیص تصاویر جعلی بصورت عمیق تر و معتبرتر کمک کرده است. در وب سایت www.whichfaceisreal.com ، کاربران می توانند بررسی کنند که آیا قادر به تقلب از عکس های اصلی هستند. پروفسور Thorsten Holz از رئیس امنیت سیستم می گوید: “در عصر اخبار جعلی ، اگر کاربران توانایی تشخیص تصاویر تولید شده از رایانه از تصاویر واقعی را نداشته باشند ، می توانند مشکل ایجاد کنند.”

محققان مستقر در بوخوم برای تجزیه و تحلیل خود از مجموعه داده هایی استفاده کردند که اساس صفحه فوق را “کدام چهره واقعی است” نیز تشکیل می دهند. در این پروژه میان رشته ای ، جوئل فرانک ، تورستن آیزنهاوفر و پروفسور تورستن هولز از بخش امنیت سیستم ها با استاد آسجه فیشر از بخش یادگیری ماشینی و همچنین لی شنودر و پروفسور دوروته کولوسا از بخش پردازش سیگنال دیجیتال همکاری کردند.

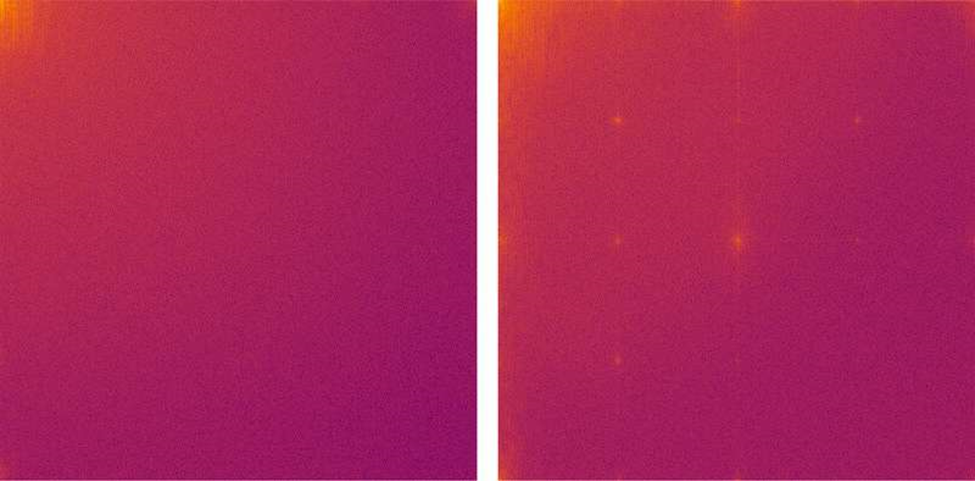

تصاویر افرادی که به دامنه فرکانس تبدیل شده اند: گوشه فوقانی سمت چپ بالای مناطق تصویر با فرکانس پایین را نشان می دهد ، گوشه پایین سمت راست نشانگر مناطق با فرکانس بالا است. در سمت چپ ، می توانید تغییر یک عکس از یک شخص واقعی را مشاهده کنید: دامنه فرکانس به طور مساوی توزیع می شود. تبدیل عکس تولید شده توسط رایانه (سمت راست) شامل یک ساختار شبکه مشخصه در محدوده فرکانس بالا – یک مصنوع معمولی است. اعتبار: RUB ، Lehrstuhl für Systemsicherheit

این عکس تجزیه و تحلیل فرکانس آثار باستانی معمولی را نشان می دهد

تجزیه و تحلیل نشان داده است که تصاویر تولید شده توسط GANs موارد قدیمی را در محدوده فرکانس بالا نشان می دهند. به عنوان مثال ، یک ساختار شبکه معمولی در نمایش فرکانس تصاویر جعلی پدیدار می شود. جوئل فرانک از رئیس صندوق امنیت سیستم ها توضیح می دهد: “آزمایش های ما نشان داد كه این آثار قدیمی فقط در تصاویر تولید شده توسط GAN رخ نمی دهند. آنها یك مشكل ساختاری همه الگوریتم های یادگیری عمیق هستند.” فرانک می افزاید: “ما فرض می کنیم که آثار قدیمی شرح داده شده در مطالعه ما همیشه به ما خواهند گفت که آیا این تصویر یک تصویر جعلی عمیق است که توسط یادگیری ماشینی ایجاد شده است.” “تجزیه و تحلیل فرکانس یک روش مؤثر برای تشخیص خودکار تصاویر تولید شده توسط رایانه است.”

https://techxplore.com