1 آوریل 2025-پروژه ACHILLES با بزرگترین چالشهای هوش مصنوعی مواجه است: اعتماد و کارایی، راهحلهای اخلاقی و تاثیرگذار را هموار میکند.

هوش مصنوعی (AI) به سرعت در حال گسترش در سراسر مراقبت های بهداشتی، مالی، خدمات عمومی و زندگی روزمره است. با این حال، در اعتماد و کارایی با پاشنه آشیل دائمی مواجه است. از آنجایی که سیستمهای پیشرفته وظایف تصمیمگیری حیاتیتری را بر عهده میگیرند، درخواستهای جامعه برای هوش مصنوعی منصفانه، حفظ حریم خصوصی و محیطزیست هوشیار قویتر میشود.

چشم انداز هوش مصنوعی اروپا در حال حاضر توسط موج جدیدی از مقررات شکل گرفته است، به ویژه قانون هوش مصنوعی اتحادیه اروپا، که یک رویکرد مبتنی بر ریسک را اجرا می کند تا اطمینان حاصل شود که برنامه های کاربردی هوش مصنوعی الزامات سختگیرانه برای ایمنی، انصاف و حاکمیت داده را برآورده می کنند. در مقابل این پسزمینه، پروژه ACHILLES با حمایت 8 میلیون یورویی از Horizon Europe، با هدف ایجاد چارچوبی جامع که امکان ایجاد محصولات مبتنی بر هوش مصنوعی را فراهم میکند که سبکتر (از لحاظ زیستمحیطی و محاسباتی پایدار)، شفافتر (شفاف، قابل تفسیر، و سازگار) و ایمنتر (محکمتر، حفظ حریم خصوصی، و سازگار) هستند.

کنسرسیوم چند رشته ای: تخصص در هر بعد هوش مصنوعی

نقطه قوت اصلی پروژه ACHILLES کنسرسیوم متنوع آن است که از 16 سازمان پیشرو از ده کشور تشکیل شده است که هر کدام دانش تخصصی را به پروژه می آورند. دانشگاهها و مؤسسات پیشرو، بهمنظورعدالت، هوش مصنوعی قابل توضیح، تکنیکهای حفظ حریم خصوصی و کارایی مدل، پیشرفتهای پیشرفته را انجام میدهند. شرکتهای با فناوری پیشرفته و شرکتهای کوچک و متوسط توسعه ابزار، نوآوری دادهها و پایلوتهای اعتبارسنجی را هدایت میکنند تا مطمئن شوند راهحلهای ACHILLES نیازهای دنیای واقعی را برآورده میکنند. سازمانهای مراقبتهای بهداشتی و بالینی مجموعه دادههای پزشکی حساس و تخصص عملی در تشخیص را به ارمغان میآورند و به ایجاد راهحلهای هوش مصنوعی سلامت قوی کمک میکنند.

مراکز مشهور تحقیقات حقوقی و متخصصان اخلاق تضمین می کنند که ACHILLES با قوانین در حال ظهور قانون هوش مصنوعی اتحادیه اروپا، قانون حاکمیت داده، GDPR همسو می شود. آنها همچنین تغییرات نظارتی آینده را پیش بینی می کنند تا به پروژه کمک کند تا در خط مقدم رعایت سیاست ها باقی بماند. متخصصان علوم باز، ارتباطات، و ابتکارات بهره برداری به هماهنگی کارگاه های بین رشته ای، تعامل با نهادهای استاندارد سازی کمک می کنند و اطمینان حاصل می کنند که خروجی های پروژه به مخاطبان گسترده ای برسد.

این ترکیب غنی از دیدگاهها تضمین میکند که ملاحظات اخلاقی، قانونی و اجتماعی در کنار ماژولهای فنی توسعه داده میشوند، که منجر به رویکردی جامع به چالشهای پیچیده توسعه هوش مصنوعی میشود.

اتصال به قانون هوش مصنوعی اتحادیه اروپا و مقررات گسترده تر

یکی از اهداف اصلی ACHILLES ساده کردن انطباق با مقررات در حال تحول، به ویژه قانون هوش مصنوعی اتحادیه اروپا است که شامل موارد زیر است:

- هم ترازی مبتنی بر ریسک: تطبیق سطح ریسک هر جزء هوش مصنوعی با بررسی های مناسب، از ممیزی داده ها تا کاهش تعصب.

- حریم خصوصی و حاکمیت داده: اطمینان از اینکه راه حل ها با الزامات GDPR، قانون حاکمیت داده و چارچوب های مرتبط مطابقت دارند یا از آنها فراتر می روند.

- هوش مصنوعی سبز: ادغام کارایی مدل و بهینهسازیهای استقرار برای کمک به سازمانها برای دستیابی به اهداف پایداری که در قرارداد سبز اروپا مشخص شده است.

در حالی که انطباق می تواند ترسناک به نظر برسد، ACHILLES بر یک چارچوب سه ستونی متکی است که اصرار قانون هوش مصنوعی بر پاسخگویی قوی را منعکس می کند:

- اهداف: اهداف به وضوح مشخص شده با مقررات، استانداردها به عنوان مثال، ISO/IEC 42001، و بهترین شیوهها همسو هستند.

- پشتیبانی از پایبندی: ابزارها و فرآیندهای عملی که در طول چرخه عمر هوش مصنوعی تعبیه شدهاند و اطمینان حاصل میکنند که انطباق داخلی است، نه شکل پیچ و مهره.

- راستیآزمایی: یک فرآیند حسابرسی قوی که ترکیبی از دادهها و کارتهای مدل و نظارت مستمر برای تأیید اعتبار هر مرحله از اهداف انطباق یا فراتر از آن است.

چرخه تکراری: از ایده تا استقرار و بازگشت

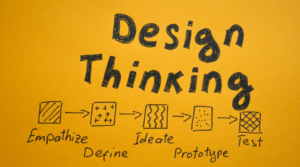

ACHILLES با الهام از آزمایشات بالینی، با مراحل توسعه و آزمایش جداگانه و ارزیابی غیر قطعی، یک چرخه توسعه تکراری را ابداع کرده است که از چهار دیدگاه (با پنج مرحله) حرکت می کند. هر مرحله تضمین میکند که ارزشهای انسانی، حریم خصوصی دادهها، کارایی مدل و پایداری استقرار در اولویت باقی میمانند.

- انسان محور (شروع): طراحی حساس به ارزش (VSD) و کارگاههای طراحی مشترک نیازهای کاربر نهایی، ارزشهای اجتماعی و محدودیتهای قانونی اولیه را برای ترسیم آنها در مشخصات فنی جلب میکنند. ارزیابیهای تاثیر اخلاقی خطرات بالقوه را برجسته میکند و مسیر راهحل هوش مصنوعی را از روز اول شکل میدهد.

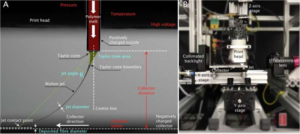

- عملیات داده محور: ممیزی و اعتبارسنجی داده ها با شناسایی نقاط پرت، اطمینان از تنوع و کیفیت داده ها. شناسایی و کاهش تعصب با استفاده از تکنیک های پیشرفته برای تولید مجموعه داده های آموزشی نماینده و منصفانه (به عنوان مثال، استفاده از داده های مصنوعی)؛ بررسی حریم خصوصی با ابزارهای خودکار برای شناسایی و ناشناس کردن داده های شخصی مطابق با دستورالعمل های GDPR

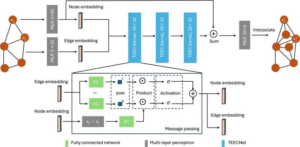

- استراتژی های مدل محور: آموزش منابع داده های توزیع شده بدون متمرکز کردن اطلاعات حساس (به عنوان مثال، یادگیری فدرال)، کاهش شدید خطر حفظ حریم خصوصی؛ جنس داده های مصنوعی ، با حفظ ویژگیهای آماری مهم، مدلها را قویتر کرده یا دادههای واقعی را جایگزین میکند. ابزارهای کارآمد مانند هرس، کمی سازی و تنظیم کارآمد فراپارامتر برای کاهش مصرف انرژی و زمان آموزش.

- بهینهسازیهای مبتنی بر استقرار: فشردهسازی مدل برای به حداقل رساندن ردپای حافظه و زمان استنتاج مدل برای صرفهجویی در مصرف انرژی و هزینه. توصیههای زیرساختی در مورد مدلهای در حال اجرا بر روی پردازندههای گرافیکی ابری، FPGA یا دستگاههای لبه بر اساس هزینه عملکرد؛ و اهداف پایداری

- انسان محور (پایان): هوش مصنوعی قابل توضیح (XAI) و کمی سازی عدم قطعیت، ارائه نتایج قابل تفسیر، برجسته کردن موارد لبه بالقوه، و اندازه گیری میزان اطمینان مدل. نظارت مستمر برای ردیابی انحراف عملکرد، انصاف حسابرسی، و شروع خودکار آموزش مجدد در صورت انباشته شدن سوگیری ها یا اشتباهات. گزارش دهی نیمه خودکار با تولید «کارتهای» دادههای پویا/مدل که منعکسکننده بروشورهای دارویی است، دستورالعملهای استفاده، محدودیتهای شناخته شده و سطوح خطر را خلاصه میکند.

این چرخه تکراری تضمین میکند که راهحلهای هوش مصنوعی نسبت به نیازهای دنیای واقعی پاسخگو میمانند و با تکامل مقررات و انتظارات اجتماعی سازگار باقی میمانند.

یک نوآوری برجسته در ACHILLES، محیط توسعه یکپارچه (IDE) است که برای پر کردن شکاف بین تصمیمگیرندگان، توسعهدهندگان و کاربران نهایی در طول چرخه عمر هوش مصنوعی طراحی شده است و از طریق این امکان میدهد:

- طراحی مبتنی بر مشخصات: تضمین می کند که هر راه حل هوش مصنوعی از همان ابتدا به الزامات انطباق و نیازهای کاربر که توسط مشترک ایجاد شده است، پایبند است. هر تکرار از داده ها و مدیریت مدل را با هنجارهای تعیین شدهGDPR، قانون هوش مصنوعی اتحادیه اروپا، و غیرههماهنگ می کند.

- مجموعه ابزار جامع: عملکردهای پیشرفته از طریق APIها را برای تشخیص سوگیری، ممیزی داده ها، نظارت بر مدل و حفظ حریم خصوصی ارائه می دهد. آموزش مدل کم مصرف و استنتاج را از طریق هرس کردن، کمی سازی و سایر شیوه های هوش مصنوعی سبز تسهیل می کند.

- Smart Copilot به عنوان یک دستیار مبتنی بر هوش مصنوعی برای هدایت توسعهدهندگان در زمان واقعی عمل میکند، بهترین شیوهها را پیشنهاد میکند، دستورالعملهای نظارتی مربوطه را ارائه میکند و مراحل بعدی را برای استقرار کارآمد یا حفظ حریم خصوصی توصیه میکند.

هدف رویکرد یکپارچه IDE از ابتدا تا استقرار و فراتر از آن، حذف حدس و گمان در مورد انطباق و پایداری است و اتخاذ استراتژیهای هوش مصنوعی مسئولانه را برای سازمانها سادهتر و شهودیتر میکند.

چهار مورد استفاده در دنیای واقعی: اثبات سازگاری و تاثیر

ACHILLES چارچوب خود را در بخشهای مختلف تأیید میکند، که سطوح مختلف ریسک، شدت نظارتی و حساسیت داده را منعکس میکند:

- مراقبت های بهداشتی: تشخیص های چشمی (به عنوان مثال، غربالگری گلوکوم) تصاویر بالینی را با داده های بیمار، با الزامات قوی در حفظ حریم خصوصی، قابلیت تفسیر و گزارش شفاف ترکیب می کند.

- تأیید هویت: بررسی اسناد و تطبیق چهره را بهطور خودکار انجام میدهد در حالی که تعصبات را به حداقل میرساند و محدودیتهای شدید حریم خصوصی را مدیریت میکند. بیشتر نشان میدهد که چگونه پایش مدل مستمر به انحراف دادهها به عنوان مثال، فرمتهای ID جدید صادر شده رسیدگی میکند.

- ایجاد محتوا (SCRIPTA): فیلمنامههای تولید شده توسط هوش مصنوعی برای فیلمها یا آثار ادبی، با نظارت اخلاقی برای فیلتر کردن محتوای مضر یا دارای حق نسخهبرداری، تعادل بین خلاقیت و سئولیتپذیری.

- داروسازی (HERA): نظارت بر انطباق و مدیریت دانش به کمک هوش مصنوعی برای سادهسازی آزمایشهای بالینی و تضمین کیفیت. اهمیت قابلیت اطمینان داده ها را در الزامات پیچیده نظارتی نشان می دهد.

هر سناریو در چرخه تکراری ACHILLES، از طراحی حساس به ارزش تا ممیزی مستمر پس از استقرار، اجرا میشود. در طول این موارد استفاده، ACHILLES از فرآیند Z-Inspection® برای ارزیابی هوش مصنوعی قابل اعتماد استفاده میکند و چارچوبی ساختاریافته برای ارزیابی میزان همسویی راهحلهای پروژه با اصول اخلاقی، نیازهای اجتماعی و الزامات قانونی ارائه میدهد.

ACHILLES موفقیت را در چندین کلید دنبال می کند .شاخص های عملکرد (KPIs)، شامل اما نه محدود به:

- کاهش سوگیری: کاهش تا 40 درصد از سوگیری شناسایی شده در معیارهای تعریف شده و مجموعه داده های دنیای واقعی.

- معیارهای حریم خصوصی: داده های مصنوعی با کمتر از 5٪ کاهش عملکرد نسبت به داده های واقعی و 90٪ + بررسی های انطباق برای اطلاعات شخصی کاربر.

- اعتماد و رضایت کاربر: نظرسنجی های قبل و بعد برای کاربران نهایی و توسعه دهندگان، با هدف 30 تا 40 درصد بهبود در عادلانه بودن و درک شفافیت هوش مصنوعی، از جمله حداقل پنج مطالعه کاربر در تعامل انسان و هوش مصنوعی.

- کاهش انرژی: حداقل 35٪ ژول کمتر در هر پیش بینی نسبت به خطوط پایه تعیین شده و 50٪ + پارامترهای شبکه عصبی هرس شده با کمتر از 5٪ کاهش عملکرد.

ACHILLES در نوامبر 2024 شروع به کار کرد و چهار سال طول می کشد. مراحل کلیدی عبارتند از:

سال 1: طراحی معماری اصلی، نگاشت چارچوب اخلاقی/قانونی، و کار اولیه بر روی جعبه ابزار فنی با الهام از موارد استفاده در دنیای واقعی.

سال 2: نسخه اولیه نسخه اولیه (شامل جعبه ابزار انطباق و عملیات داده های پیشرفته) و بهبودهای تکراری که از طریق پایلوت های اعتبارسنجی در دنیای واقعی آزمایش شدند.

سال 3:افزایش سناریوهای نمایشی، اصلاح ماژولهای قوی حفظ حریم خصوصی و ادغام نتایج در استقرارهای خاص بخش.

سال 4: انتشار بتا ACHILLES IDE، اعتبار سنجی نهایی در موارد استفاده در دنیای واقعی (از جمله مطالعات جامع کاربر)، و یک استراتژی بهره برداری تلفیقی برای گسترش چارچوب فراتر از طول عمر پروژه.

در هر مرحله، شرکا در کارگاههای بینرشتهای ملاقات میکنند تا پیشرفت را بررسی کنند، یافتهها را به شیوهای علمی باز به اشتراک بگذارند، و بینشهای خود را به نهادهای استاندارد منتقل کنند. تا پایان پروژه، ACHILLES قصد دارد یک اکوسیستم کامل برای هوش مصنوعی مسئول، سبز و قانونی ارائه دهد.

پروژه ACHILLES با هدایت اصول Horizon Europe، علم و همکاری باز را ترویج می کند:

- بستههای ابزار منبع باز و انتشار علمی: بسیاری از ماژولها و کتابخانهها بر روی پلتفرمهای باز مانند GitHubتحت مجوزهای مجاز برای به حداکثر رساندن ورودی جامعه منتشر خواهند شد. این و سایر نتایج علمی در کنفرانس های کلیدی و مجلات با دسترسی آزاد به اشتراک گذاشته خواهد شد.

- کارگاه های عمومی: رویدادهای بین رشته ای منظم توسعه دهندگان، سیاست گذاران، اخلاق شناسان و جامعه مدنی را برای اصلاح ماژول های سیستم متحد می کند.

- تعامل با نهادهای استاندارد: اعضای کنسرسیوم به طور فعال در بحثهای ISO مرتبط با هوش مصنوعی، کمیتههای CEN-CENELEC و سایر گروههای کاری برای کمک به شکلدهی استانداردهای فنی آینده در مورد اشتراکگذاری داده، XAI و حریم خصوصی مشارکت خواهند داشت.

این فرهنگ باز بودن، اکوسیستم گستردهتری از توسعه هوش مصنوعی مسئول را تقویت میکند که در آن بهترین شیوهها به اشتراک گذاشته میشوند، بهبود مییابند و به طور مداوم در زمینههای دنیای واقعی تأیید میشوند.

ACHILLES طرحی برای هوش مصنوعی مدرن ارائه می دهد که به ارزش های انسانی احترام می گذارد، مقررات سختگیرانه را رعایت می کند و به طور موثر عمل می کند. این پروژه با ترکیب پیشرفتهای فنی با سختگیری اخلاقی- قانونی، نشان میدهد که چگونه هوش مصنوعی میتواند نیروی خوبی باشد: شفاف، فراگیر و پایدار. معماری باز و ماژولار پروژه، که در ACHILLES IDE کاربرپسند تجسم یافته است، تعهد اروپا به رهبری در حاکمیت داده و حاکمیت دیجیتال، به حداقل رساندن اثرات زیست محیطی، و به حداکثر رساندن شفافیت، انصاف و اعتماد را نشان می دهد.

با نزدیکتر شدن اجرای کامل قانون هوش مصنوعی اتحادیه اروپا، پروژههایی مانند ACHILLES برای ایجاد پل ارتباطی با سیاستها و عمل بسیار حیاتی هستند. هدف این است که اطمینان حاصل شود که هوش مصنوعی پتانسیل خود را برای بهبود زندگی و نتایج کسب و کار بدون به خطر انداختن اخلاقیات، حریم خصوصی یا پایداری انجام می دهد. انطباق یک مسدود کننده نوآوری نیست و از طریق یک حلقه بازخورد دقیق و مستمر، ACHILLES معیاری را برای هوش مصنوعی قابل اعتماد، نه تنها در اروپا بلکه در سطح جهانی تعیین می کند.