4 نوامبر 2024 -توسط تس مالون، موسسه فناوری جورجیا-اعتبار: دامنه عمومی Pixabay/CC0

تصور کنید در حالی که وسیله نقلیه شروع به انحراف از جاده می کند، مسافر یک ماشین خودران هستید. این یک سنسور معیوب نیست که موقعیت خطرناک را ایجاد کند، بلکه یک حمله سایبری است. هکرها میتوانند به شبکههای عصبی یادگیری عمیق (DL) در قلب سیستم کامپیوتری خودرو دسترسی داشته باشند و امنیت مسافران و سایر رانندگان و عابران پیاده را به خطر بیندازند.

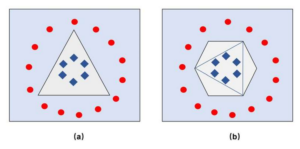

توقف چنین حملات سایبری ابتدا نیازمند درک آنهاست، اما این می تواند چالش برانگیز باشد. یافتن شبکه عصبی عمیق دقیق یک سیستم محاسباتی موانع زیادی دارد. آنها اغلب انحصاری هستند و بنابراین بدون مداخله قانونی قابل توجه برای بازرسان غیرقابل دسترسی هستند. یکی دیگر از مشکلات رایج این است که آنها به طور مکرر به روز می شوند و دسترسی محققین به آخرین تکرار شبکه را دشوار می کند.

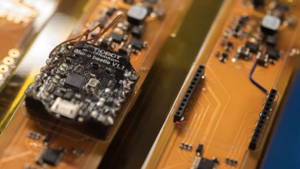

اما ابزار جدیدی از Georgia Tech میتواند این بدافزار مرموز را در شبکههای عصبی بیشمار در همه چیز از ماشینهای خودران گرفته تا پایگاه داده سرگرمی IMDB باز کند. AI Psychiatry (AiP) یک ابزار پزشکی قانونی پس از مرگ سایبری است که از هوش مصنوعی برای بازیابی مدلهای دقیقی که یک دستگاه آسیبدیده روی آنها کار میکند، استفاده میکند و کشف میکند که خطای مرگبار کجا رخ داده است.

برندان سالتافورماجیو، دانشیار با انتصابات مشترک در دانشکده امنیت سایبری و حریم خصوصی و دانشکده مهندسی برق و کامپیوتر (ECE) گفت ما به ماشین های خودران در زندگی خود و ChatGPT به حرفه خود اعتماد می کنیم، اما وقتی این سیستم ها از کار می افتند، چگونه می خواهیم آنها را بررسی کنیم؟.

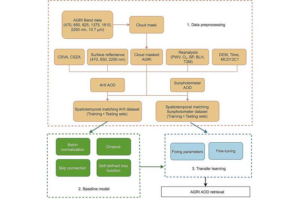

AiP می تواند مدل DL اصلی را هم در حافظه شبکه محلی و هم در واحد پردازش گرافیکی که شبکه را آموزش می دهد، بازیابی کند. میتواند این کار را بدون دانش خاصی از چارچوب، پلتفرم یا نسخه مدل انجام دهد. در عوض، مدل را با استفاده از آنچه Saltaformaggio به عنوان “سرنخ” یا اجزای مشترک در همه شبکه های عصبی می نامد، بازسازی می کند.

اینها شامل وزنها، سوگیریها، شکلها و لایههایی از تصویر حافظه مدل است – مجموعهای ثابت از بیتها و بایتها که وقتی مدل به طور معمول کار میکند. تصویر حافظه بسیار مهم است زیرا AiP را قادر می سازد آن را با مدل پس از حمله مقایسه کند.

دیوید اویگنبلیک، دانشجوی دکترای ECE، گفت: «این مدلها اغلب اطلاعات خود را بر اساس محیط فعلیشان در حین حرکت اصلاح میکنند، بنابراین حمله ممکن است در نتیجه مسموم کردن اطلاعاتی که یک مدل خاص میآموزد توسط مهاجم رخ دهد. “ما تعیین کردیم که یک تصویر حافظه می تواند تمام تغییراتی را که در طول زمان اجرا رخ می دهد، ثبت کند.”

هنگامی که مدل بازیابی شد، AiP میتواند آن را روی دستگاه دیگری اجرا کند، و به محققان اجازه میدهد آن را به طور کامل آزمایش کنند تا مشخص کنند نقصها کجاست. AiP با نسخههای مختلف چارچوبهای یادگیری ماشینی محبوب (TensorFlow و PyTorch) و مجموعههای داده (CIFAR-10، LISA، و IMDB) آزمایش شده است. 30 مدل را با 100 درصد دقت بازیابی و میزبانی مجدد کرد.

Saltaformaggio گفت: «قبل از تحقیقات ما، نمیتوانستید به «صحنه جرم» سایبری بروید و سرنخهایی پیدا کنید، زیرا هیچ تکنیکی برای انجام آن وجود نداشت. این همان چیزی است که ما در حال حاضر در آزمایشگاه پزشکی قانونی سایبری پیشگام هستیم – تکنیک هایی برای بیرون آوردن این شواهد از صحنه جرم.”

ابزارهایی مانند AiP به محققین سایبری اجازه میدهد تا بلافاصله کل تصویر را ببینند. حل جرایم سایبری می تواند به جلوگیری از جرایم آینده، از محافظت از داده های کاربر گرفته تا نگه داشتن خودرو در جاده ها کمک کند.