19 آگوست 2024 – توسط آرون جی اسنوسول، گفتگو-اعتبار: دامنه عمومی Pixabay/CC0

پیام رسانان و خبرسازان هوش مصنوعی (AI) با صحبت از یک فاجعه آمیز قریب الوقوع “فروپاشی مدل” پایان تبلیغات مولد هوش مصنوعی را پیش بینی می کنند.

اما این پیش بینی ها چقدر واقعی هستند؟ و به هر حال فروپاشی مدل چیست؟

«فروپاشی مدل» که در سال 2023 مورد بحث قرار گرفت، اما اخیراً رایج شده است، به یک سناریوی فرضی اشاره دارد که در آن سیستمهای هوش مصنوعی آینده به دلیل افزایش دادههای تولید شده توسط هوش مصنوعی در اینترنت به تدریج احمقانه میشوند.

سیستم های هوش مصنوعی مدرن با استفاده از یادگیری ماشین ساخته می شوند. برنامه نویسان ساختار ریاضی زیربنایی را تنظیم می کنند، اما “هوش” واقعی از آموزش سیستم برای تقلید الگوها در داده ها ناشی می شود.

اما نه هر داده ای. محصول فعلی سیستمهای هوش مصنوعی مولد به دادههای با کیفیت بالا و تعداد زیادی از آن نیاز دارد.

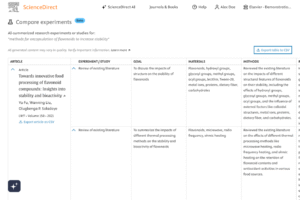

برای منبع این داده ها، شرکت های فناوری بزرگ مانند OpenAI، گوگل، متا و انویدیا به طور مداوم اینترنت را جست و جو می کنند و ترابایت محتوا برای تغذیه ماشین ها جمع آوری می کنند. اما از زمان ظهور سیستمهای هوش مصنوعی در دسترس و مفید در سال 2022، مردم به طور فزایندهای محتوایی را بارگذاری و به اشتراک میگذارند که بخشی یا کل آن توسط هوش مصنوعی ساخته شده است.

در سال 2023، محققان به این فکر افتادند که آیا میتوانند به جای دادههای تولید شده توسط انسان، تنها به دادههای ایجاد شده توسط هوش مصنوعی برای آموزش تکیه کنند.

انگیزه های زیادی برای ساخت این کار وجود دارد. علاوه بر تکثیر در اینترنت، محتوای تولید شده با هوش مصنوعی بسیار ارزانتر از منبع دادههای انسانی است. همچنین جمع آوری انبوه از نظر اخلاقی و قانونی مشکوک نیست.

با این حال، محققان دریافتند که بدون دادههای انسانی با کیفیت بالا، سیستمهای هوش مصنوعی که بر روی دادههای ساختهشده با هوش مصنوعی آموزش دیدهاند، با یادگیری هر مدل از مدل قبلی، گنگتر و احمقتر میشوند. این مانند نسخه دیجیتالی مشکل همخونی است.

به نظر می رسد این “آموزش ناپسند” منجر به کاهش کیفیت و تنوع رفتار مدل شود. کیفیت در اینجا تقریباً به معنای ترکیبی از مفید، بی ضرر و صادق بودن است. تنوع به تنوع در پاسخ ها اشاره دارد و دیدگاه های فرهنگی و اجتماعی افراد در خروجی های هوش مصنوعی نشان داده می شود.

به طور خلاصه: با استفاده زیاد از سیستمهای هوش مصنوعی، میتوانیم همان منبع دادهای را که برای مفید کردن آنها در وهله اول نیاز داریم، آلوده کنیم.

آیا فناوری های بزرگ نمی توانند محتوای تولید شده توسط هوش مصنوعی را فیلتر کنند؟ .شرکتهای فناوری در حال حاضر زمان و هزینه زیادی را صرف تمیز کردن و فیلتر کردن دادههایی که مشکل دارند میکنند، بهطوریکه یکی از کارشناسان داخلی اخیراً به اشتراکگذاری میکند که گاهی تا ۹۰ درصد از دادههایی را که در ابتدا برای مدلهای آموزشی جمعآوری میکنند دور میاندازند.

با افزایش نیاز به حذف محتوای تولید شده توسط هوش مصنوعی، این تلاشها ممکن است سختتر شوند. اما مهمتر از آن، در دراز مدت، تشخیص محتوای هوش مصنوعی در واقع سخت تر و دشوارتر می شود. این باعث میشود که فیلتر کردن و حذف دادههای مصنوعی به بازی کاهش بازده (مالی) تبدیل شود.در نهایت، تحقیقات تا کنون نشان می دهد که ما نمی توانیم به طور کامل داده های انسانی را از بین ببریم. به هر حال، این جایی است که “من” در هوش مصنوعی از آنجا می آید.

آیا ما به سمت یک فاجعه پیش می رویم؟

نکاتی وجود دارد که توسعهدهندگان باید سختتر کار کنند تا دادههای با کیفیت بالا تهیه کنند. به عنوان مثال، اسناد همراه با انتشار GPT-4 تعداد بی سابقه ای از کارکنان درگیر در بخش های مربوط به داده های پروژه را نشان می دهد.همچنین ممکن است دادههای انسانی جدید ما تمام شود. برخی تخمین ها می گویند که مجموعه داده های متنی تولید شده توسط انسان ممکن است تا سال 2026 از بین برود.

احتمالاً چرا OpenAI و دیگران برای تقویت شراکت انحصاری با غولهای صنعت مانند Shutterstock، Associated Press و NewsCorp رقابت میکنند. آنها دارای مجموعه های اختصاصی بزرگی از داده های انسانی هستند که به راحتی در اینترنت عمومی در دسترس نیستند.

با این حال، دورنمای فروپاشی مدل فاجعه بار ممکن است اغراق آمیز باشد. بیشتر تحقیقات تاکنون به مواردی می پردازد که داده های مصنوعی جایگزین داده های انسانی می شوند. در عمل، داده های انسان و هوش مصنوعی احتمالاً به صورت موازی جمع می شوند، که احتمال فروپاشی را کاهش می دهد.

محتملترین سناریوی آینده همچنین شاهد استفاده از اکوسیستمی از پلتفرمهای هوش مصنوعی مولد تا حدودی متنوع برای ایجاد و انتشار محتوا خواهد بود، نه یک مدل یکپارچه. این همچنین استحکام در برابر فروپاشی را افزایش می دهد.این دلیل خوبی برای تنظیمکنندهها برای ترویج رقابت سالم با محدود کردن انحصارات در بخش هوش مصنوعی و تامین مالی توسعه فناوری منافع عمومی است.

همچنین خطرات ظریف تری از محتوای بیش از حد ساخته شده توسط هوش مصنوعی وجود دارد.

سیل محتوای مصنوعی ممکن است تهدیدی وجودی برای پیشرفت توسعه هوش مصنوعی نباشد، اما منافع عمومی دیجیتال اینترنت (انسانی) را تهدید میکند.

به عنوان مثال، یک سال پس از انتشار ChatGPT، محققان متوجه کاهش 16 درصدی فعالیت در وب سایت برنامه نویسی StackOverflow شدند. این نشان می دهد که کمک هوش مصنوعی ممکن است تعاملات فرد به فرد را در برخی از جوامع آنلاین کاهش دهد.

تولید بیش از حد از شرکت مبتنی بر هوش مصنوعی ومزارع ntent همچنین یافتن محتوایی که طعمه کلیکی پر از تبلیغات نباشد را دشوارتر می کند.

تشخیص قابل اعتماد بین محتوای تولید شده توسط انسان و تولید شده توسط هوش مصنوعی غیرممکن شده است. یکی از روشهای رفع این مشکل، نشانگذاری یا برچسبگذاری محتوای تولید شده توسط هوش مصنوعی است، همانطور که من و بسیاری دیگر اخیراً تاکید کردهایم و در قوانین موقت اخیر دولت استرالیا منعکس شده است.

خطر دیگری نیز وجود دارد. از آنجایی که محتوای تولید شده توسط هوش مصنوعی به طور سیستماتیک همگن می شود، ما در خطر از دست دادن تنوع فرهنگی-اجتماعی هستیم و برخی از گروه های مردم حتی ممکن است پاک شدن فرهنگی را تجربه کنند. ما به تحقیقات بین رشته ای در مورد چالش های اجتماعی و فرهنگی ناشی از سیستم های هوش مصنوعی نیاز فوری داریم.

تعاملات انسانی و داده های انسانی مهم هستند و ما باید از آنها محافظت کنیم. به خاطر خودمان و شاید هم به خاطر خطر احتمالی سقوط مدل آینده.