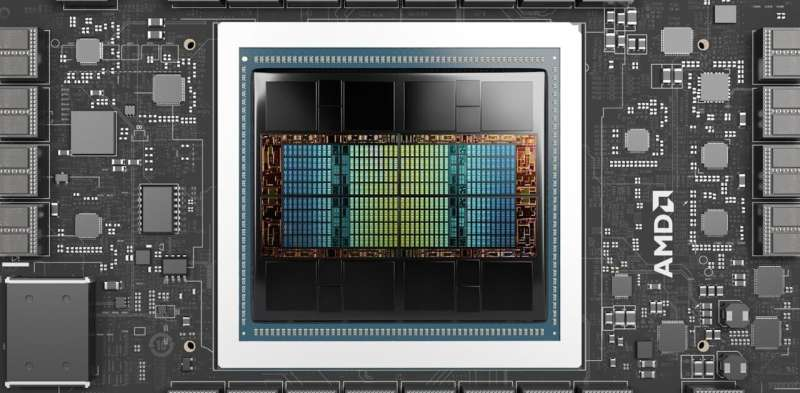

6 مارس 2024 -نوشته کنراد ساندرسون،اعتبار AMD-از آنجایی که جهان برای استفاده از آخرین موج فناوریهای هوش مصنوعی عجله دارد، یک قطعه سختافزار با فناوری پیشرفته به یک کالای شگفتآور تبدیل شده است: واحد پردازش گرافیکی یا GPU.

یک پردازنده گرافیکی پیشرفته می تواند ده ها هزار دلار فروخته شود و سازنده پیشرو NVIDIA با افزایش تقاضا برای محصولاتش، ارزش بازار خود را به بیش از 2 تریلیون دلار افزایش داده است.

پردازندههای گرافیکی نیز فقط محصولات پیشرفته هوش مصنوعی نیستند. پردازندههای گرافیکی کمتری در گوشیها، لپتاپها و کنسولهای بازی نیز وجود دارد.

تا به حال احتمالاً از خود می پرسید: واقعاً GPU چیست؟ و چه چیزی آنها را بسیار خاص می کند؟

GPU چیست؟

پردازندههای گرافیکی در ابتدا برای تولید و نمایش سریع صحنهها و اشیاء سه بعدی پیچیده، مانند مواردی که در بازیهای ویدیویی و نرمافزارهای طراحی به کمک رایانه دخیل هستند، طراحی شدند. پردازندههای گرافیکی مدرن کارهایی مانند فشردهسازی جریانهای ویدئویی را نیز انجام میدهند.

“مغز” اکثر رایانه ها تراشه ای است به نام واحد پردازش مرکزی (CPU). پردازندهها را میتوان برای تولید صحنههای گرافیکی و از حالت فشردهکردن ویدیوها استفاده کرد، اما معمولاً در مقایسه با پردازندههای گرافیکی در انجام این کارها بسیار کندتر هستند. CPU ها برای کارهای محاسباتی عمومی مانند پردازش کلمه و مرور صفحات وب مناسب تر هستند.

GPU ها چه تفاوتی با CPU دارند؟

یک CPU معمولی مدرن از 8 تا 16 هسته تشکیل شده است که هر یک می توانند وظایف پیچیده را به صورت متوالی پردازش کنند.از سوی دیگر، پردازندههای گرافیکی دارای هزاران هسته نسبتاً کوچک هستند که برای دستیابی به پردازش کلی سریع، همه به طور همزمان (“موازی”) طراحی شدهاند. این باعث می شود آنها برای کارهایی مناسب باشند که به تعداد زیادی عملیات ساده نیاز دارند که می توانند همزمان انجام شوند، نه یکی پس از دیگری.پردازندههای گرافیکی سنتی دو نوع اصلی دارند.

اول، تراشههای مستقلی وجود دارند که اغلب به صورت کارتهای افزودنی برای رایانههای رومیزی بزرگ ارائه میشوند. دوم، پردازندههای گرافیکی ترکیب شده با یک CPU در یک بسته تراشه، که اغلب در لپتاپها و کنسولهای بازی مانند پلیاستیشن 5 یافت میشوند. در هر دو مورد، CPU کارهای GPU را کنترل میکند.

چرا GPU ها برای هوش مصنوعی بسیار مفید هستند؟

به نظر می رسد که پردازنده های گرافیکی را می توان برای انجام کارهایی بیشتر از تولید صحنه های گرافیکی تغییر کاربری داد.

بسیاری از تکنیکهای یادگیری ماشینی که در پشت هوش مصنوعی (AI) قرار دارند، مانند شبکههای عصبی عمیق، به شدت بر اشکال مختلف «ضرب ماتریس» متکی هستند.این یک عملیات ریاضی است که در آن مجموعه های بسیار بزرگی از اعداد ضرب و با هم جمع می شوند. این عملیات به خوبی برای پردازش موازی مناسب هستند و از این رو میتوانند به سرعت توسط پردازندههای گرافیکی انجام شوند.

آینده پردازندههای گرافیکی چیست؟

به دلیل افزایش تعداد هستهها و سرعت عملکرد آنها، قدرت پردازشگرهای گرافیکی به طور پیوسته در حال افزایش است. این پیشرفتها عمدتاً ناشی از پیشرفت در تولید تراشه توسط شرکتهایی مانند TSMC در تایوان است.اندازه هر یک از ترانزیستورها – اجزای اساسی هر تراشه کامپیوتری – در حال کاهش است و به ترانزیستورهای بیشتری اجازه می دهد تا در همان مقدار فضای فیزیکی قرار گیرند.با این حال، این تمام داستان نیست. در حالی که GPU های سنتی برای کارهای محاسباتی مرتبط با هوش مصنوعی مفید هستند، اما بهینه نیستند.

همانطور که پردازندههای گرافیکی در ابتدا برای سرعت بخشیدن به رایانهها با ارائه پردازشهای تخصصی برای گرافیک طراحی شدند، شتابدهندههایی نیز وجود دارند که برای سرعت بخشیدن به وظایف یادگیری ماشین طراحی شدهاند. این شتاب دهنده ها اغلب به عنوان “GPU های مرکز داده” شناخته می شوند.

برخی از محبوب ترین شتاب دهنده ها، ساخته شده توسط شرکت هایی مانند AMD و NVIDIA، به عنوان GPU های سنتی شروع به کار کردند. با گذشت زمان، طرحهای آنها برای انجام بهتر وظایف مختلف یادگیری ماشین، به عنوان مثال با پشتیبانی از فرمت عددی کارآمدتر «مغز شناور» تکامل یافت.

شتابدهندههای دیگری مانند واحدهای پردازش تنسور گوگل و هستههای تنسیکس تنسورنت، از ابتدا برای سرعت بخشیدن به شبکههای عصبی عمیق طراحی شدهاند.

پردازندههای گرافیکی مرکز داده و سایر شتابدهندههای هوش مصنوعی معمولاً حافظه بیشتری نسبت به کارتهای الحاقی GPU سنتی دارند که برای آموزش مدلهای بزرگ هوش مصنوعی بسیار مهم است. هرچه مدل هوش مصنوعی بزرگتر باشد، توانایی و دقت بیشتری دارد.

برای تسریع بیشتر در آموزش و مدیریت مدلهای هوش مصنوعی حتی بزرگتر، مانند ChatGPT، بسیاری از پردازندههای گرافیکی مرکز داده را میتوان با هم ترکیب کرد و یک ابر رایانه را تشکیل داد. این به نرم افزار پیچیده تری نیاز دارد تا بتواند به درستی از قدرت تقسیم کردن اعداد موجود استفاده کند. رویکرد دیگر ایجاد یک شتاب دهنده بسیار بزرگ است، مانند “پردازنده در مقیاس ویفر” تولید شده توسط Cerebras.

آیا تراشه های تخصصی آینده هستند؟

CPU ها نیز ثابت نبوده اند. CPUهای اخیر AMD و Intel دارای دستورالعملهای سطح پایین داخلی هستند که اعداد مورد نیاز شبکههای عصبی عمیق را سرعت میبخشد. این عملکرد اضافی عمدتاً به وظایف “استنتاج” کمک می کند – یعنی استفاده از مدل های هوش مصنوعی که قبلاً در جاهای دیگر توسعه یافته اند.

برای آموزش مدل های هوش مصنوعی در وهله اول، هنوز به شتاب دهنده های بزرگ شبیه GPU نیاز است.

امکان ایجاد هر چه بیشتر وجود دارد؟

شتاب دهنده های تخصصی برای الگوریتم های خاص یادگیری ماشینی. به عنوان مثال، اخیراً شرکتی به نام Groq یک “واحد پردازش زبان” (LPU) تولید کرده است که به طور خاص برای اجرای مدل های زبان بزرگ در امتداد خطوط ChatGPT طراحی شده است.

با این حال، ایجاد این پردازنده های تخصصی منابع مهندسی قابل توجهی را می طلبد. تاریخ نشان می دهد که استفاده و محبوبیت هر الگوریتم یادگیری ماشینی به اوج خود می رسد و سپس کاهش می یابد – بنابراین سخت افزار تخصصی گران قیمت ممکن است به سرعت قدیمی شود.

با این حال، برای مصرف کننده معمولی، بعید است که مشکلی ایجاد کند. پردازندههای گرافیکی و سایر تراشههای موجود در محصولاتی که استفاده میکنید احتمالاً سریعتر میشوند.