17 مارس 2023 -توسط جف رنو، دانشگاه وسترن انتاریو-انتخاب تصاویر شیء نشان داده شده به ناظران انسانی و شبکه های عصبی عمیق. اعتبار Marieke Mur

وقتی انسان چهره ای آشنا یا وسیله نقلیه ای را که در حال نزدیک شدن است می بیند، فقط 100 میلی ثانیه (حدود یک دهم ثانیه) در مغز طول می کشد تا آن را شناسایی کند و مهمتر از آن، آن را در زمینه مناسب قرار دهد تا بتوان آن را درک کرد. فرد می تواند بر این اساس واکنش نشان دهد.

جای تعجب نیست که رایانهها ممکن است بتوانند این کار را سریعتر انجام دهند، اما آیا آنها به اندازه انسانها در دنیای واقعی دقیق هستند؟ بر اساس مطالعه ای که توسط ماریکه مور، متخصص تصویربرداری عصبی انجام شد، همیشه نه، و این یک مشکل است.

می توان به رایانه ها یاد داد که داده های دریافتی را پردازش کنند، مانند مشاهده چهره ها و اتومبیل ها، با استفاده از هوش مصنوعی معروف به شبکه های عصبی عمیق یا یادگیری عمیق. این نوع فرآیند یادگیری ماشینی از گره ها یا نورون های به هم پیوسته در ساختار لایه ای شبیه مغز انسان استفاده می کند.

کلمه کلیدی “شبیه” است زیرا کامپیوترها، علیرغم قدرت و نوید یادگیری عمیق، هنوز بر محاسبات انسانی و مهمتر از همه، ارتباطی که بین بدن و مغز وجود دارد، به ویژه هنگامی که صحبت از تشخیص بصری می شود، تسلط پیدا نکرده است.

مور، پروفسور مور که به طور مشترک در دپارتمانهای روانشناسی و علوم کامپیوتر منصوب شده است، میگوید: «شبکههای عصبی عمیق، اگرچه امیدوارکننده هستند، اما بهعنوان مدلهای محاسباتی کامل بینایی انسان فاصله زیادی دارند.

مطالعات قبلی نشان دادهاند که یادگیری عمیق نمیتواند شناخت بصری انسان را بهطور کامل بازتولید کند، اما تعداد کمی تلاش کردهاند تا مشخص کنند که یادگیری عمیق بینایی انسان در تقلید از کدام جنبهها ناکام است.

این تیم از یک آزمایش پزشکی غیر تهاجمی به نام مگنتوآنسفالوگرافی (MEG) استفاده کردند که میدان های مغناطیسی تولید شده توسط جریان های الکتریکی مغز را اندازه گیری می کند. مور و همکاران بینالمللی او با استفاده از دادههای MEG بهدستآمده از ناظران انسانی در حین مشاهده شی، یک نقطه کلیدی شکست را شناسایی کردند. آنها دریافتند که بخشهایی از اشیاء که به راحتی قابل نامگذاری هستند، مانند «چشم»، «چرخ» و «صورت»، میتوانند واریانس دینامیک عصبی انسان را بیش از آنچه یادگیری عمیق میتواند ارائه دهد، توضیح دهد.

مور میگوید: «این یافتهها نشان میدهد که شبکههای عصبی عمیق و انسانها ممکن است تا حدی به ویژگیهای مختلف شی برای تشخیص بصری تکیه کنند و دستورالعملهایی برای بهبود مدل ارائه کنند.

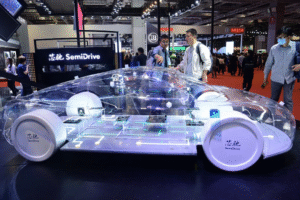

این مطالعه نشان میدهد که شبکههای عصبی عمیق نمیتوانند به طور کامل پاسخهای عصبی اندازهگیری شده در ناظران انسانی را در زمانی که افراد در حال مشاهده عکسهای اشیا، از جمله صورت و حیوانات هستند، توضیح دهند و پیامدهای عمدهای برای استفاده از مدلهای یادگیری عمیق در تنظیمات دنیای واقعی، مانند خود رانندگی وسایل نقلیه را بکار گیرند .

مور میگوید: «این کشف سرنخهایی در مورد آنچه شبکههای عصبی در تصاویر درک نمیکنند، یعنی ویژگیهای بصری که نشاندهنده دستهبندی اشیاء مرتبط با محیط زیست مانند چهرهها و حیوانات هستند، ارائه میکند. ما پیشنهاد میکنیم که شبکههای عصبی را میتوان بهعنوان مدلهایی از مغز، با دادن تجربه یادگیری بیشتر شبیه به انسان، مانند یک رژیم آموزشی که به شدت بر فشارهای رفتاری که انسان در طول توسعه تحت آن قرار میگیرند، تأکید میکند، بهبود بخشید.»

برای مثال، برای انسان مهم است که به سرعت تشخیص دهند که آیا یک شی حیوانی است که در حال نزدیک شدن است یا خیر، و اگر چنین است، حرکت بعدی بعدی آن را پیش بینی کند. ادغام این فشارها در طول آموزش ممکن است به توانایی رویکردهای یادگیری عمیق برای مدلسازی بینایی انسان کمک کند.

این کار در مجله The Journal of Neuroscience منتشر شده است.