توسط اینگرید فاضلی ، ۱۰ آگوست 2020

در سالهای اخیر ، محققان به طرز فزاینده ای تکنیک های محاسباتی را توسعه داده اند تا قابلیت های شبیه انسان را در روبات ها فعال کنند. با این حال ، اکثر تکنیک های توسعه یافته تا کنون ، صرفاً روی تولید مثل مصنوعی بر حواس بینایی و لمسی بوده است و بی توجهی به حواس دیگر را کنار گذاشته و بر حواس دیگر، مانند درک شنوایی ، تمرکز می کنند.

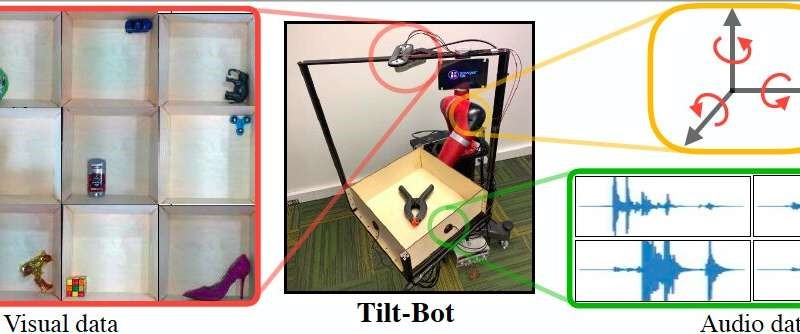

اخیراً یک تیم تحقیقاتی در دانشگاه کارنگی ملون (CMU) در مورد امکان استفاده از صدا برای توسعه روبات هایی با قابلیت سنجش پیشرفته تر تحقیقاتی را انجام داده اند و این حس نیز بررسی شده است. مقاله آنها ، که در Robotics: Science and Systems منتشر شده است ، بزرگترین مجموعه داده های مرتبط با بینایی ، صدا و تصویر را که تا به امروز گردآوری شده است را معرفی می کند . این مجموعه به عنوان یک پلتفرم رباتیک به نام Tilt-Bot collected جمع آوری شده و با طیف گسترده ای از اشیاء در تعامل است.

لرل پینتو ، یکی از محققانی که این مطالعه را انجام داده است ، می گوید: “در سیستم های یادگیری روبات ها ، ما فقط از ورودی های تصویری برای درک استفاده می کنیم ، اما انسانها دارای عملکردهای حسی بیشتری از بینایی به تنهایی هستند.” “صدا یکی از مؤلفه های اصلی یادگیری و درک محیط فیزیکی ما می باشد . بنابراین ، ما این سؤال را مطرح کردیم: چه چیزی می تواند ما را در مجموعه داده های صوتی و تصویری در مقیاس بزرگ در تعامل رباتیک یاری کند ؟. “

در اصل ، Tilt-Bot یک سینی رباتیک است که اشیاء را کج کرده و می لغزاند تا اینکه به یکی از دیواره های سینی ضربه بزنند. پینتو و همکارانش میکروفنهای تماسی را بر روی دیواره های سینی روباتیک قرار دادند تا صداهای تولید شده هنگام برخورد اشیاء به دیواره را ضبط کنند و بطور همزمان از یک دوربین برای ضبط بصری حرکات هر شی استفاده کردند.

محققان داده های صوتی و تصویری را برای بیش از 15،000 تعامل Tilt-Bot با 60 شیء مختلف جمع آوری کردند. این امر به آنها امکان می دهد یک مجموعه داده جدید صوتی و تصویری را تهیه کنند که می تواند به آموزش روبات ها برای ایجاد ارتباط بین عملکردها ، تصاویر و صداها کمک کند.

پینتو و همكارانش در مقاله خود از این مجموعه داده برای بررسی رابطه بین صدا و عمل در كاربردهای روباتیک استفاده و تعدادی از یافته های جالب را جمع آوری كردند. در مرحله اول ، آنها دریافتند که تجزیه و تحلیل ضبط صدا از اشیاء در حال حرکت و ضربه زدن به سطوح می تواند به دستگاهها اجازه دهد تا اشیاء مختلف را از هم تمیز دهند ، به عنوان مثال تمایز بین یک پیچ گوشتی فلزی و یک آچار فلزی.

پینتو توضیح داد: “یکی از نتایج اولیه جالب مطالعه ما این بود که فقط از طریق صدا می توانید نوع جسم را با دقت نزدیک به 80٪ تشخیص دهید.” وی گفت: “ما همچنین نشان دادیم كه یك دستگاه می تواند تشخیص های مبتنی بر صدا را از اشیاء یاد بگیرد كه بعداً می توانند به حل وظایف روباتیک كمك كنند. به عنوان مثال ، با شناسایی صدایی که از یک لیوان شراب خالی ایجاد می شود ، یك روبات می تواند بفهمد كه در زمان دست زدن به آن باید اقدامات متفاوتی نسبت به آن ها انجام دهد.

جالب اینجاست که پینتو و همکارانش نشان دادند که ضبط صدا گاهی اوقات می تواند اطلاعات ارزشمندتری نسبت به نمایش بصری برای حل وظایف روباتیک ارائه دهد ، زیرا می توان از آنها برای پیش بینی موثر حرکت های آینده یک شی استفاده کرد. در یک سری آزمایشات با استفاده از اشیایی که ربات در حین آموزش با آنها روبرو نشده است ، آنها دریافتند که بر مبنای اطلاعات صوتی جمع آوری شده توسط خود روبات در تعامل با این اشیاء می تواند مدل های تکاملی (یعنی نحوه بهترین دستکاری یک شیء در آینده) را به میزان 24٪ بهتراز اطلاعات بصری پیش بینی کند.

مجموعه داده های جمع آوری شده توسط این تیم از محققان در نهایت می تواند به توسعه روبات هایی کمک کند که بتوانند اقدامات و استراتژی های مرتبط با لمس اشیاء را بر اساس ضبط صدا و تصاویر جمع آوری شده در محیط اطراف خود انتخاب کنند. پینتو و همکارانش اکنون در حال برنامه ریزی برای بررسی بیشتر پتانسیل آنالیز صدا برای ایجاد روبات هایی با قابلیت های پیشرفته تر هستند.

پینتو گفت: “این کار فقط اولین قدم برای یکپارچه سازی صدا در رباتیک است.” “در کار آینده ما ، ما به دنبال کاربردهای واقعی تر صدا و اکشن خواهیم بود.”