بهروزرسانی: ۷ سپتامبر ۲۰۲۵، عکس از نویسنده: بوجان استویکوفسکی -EurekAlert

هوش مصنوعی به طور پیوسته از سرورهای ابری غولپیکر به دستگاههای روزمره مانند تلفنهای هوشمند، اتومبیلها و وسایل خانگی منتقل میشود. برای امکانپذیر کردن این امر، مدلها اغلب برای صرفهجویی در انرژی و قدرت پردازش، کوچک میشوند.مشکل این است که آنچه حذف میشود همیشه ظاهری نیست و گاهی اوقات همان محافظهایی که برای جلوگیری از خروجیهای مضر، مانند سخنان نفرتپراکن یا دستورالعملهای مجرمانه طراحی شدهاند، ضعیف یا از بین میروند.

مدلهای متنباز این خطر را تشدید میکنند – آنها را میتوان آزادانه دانلود، تغییر و به صورت آفلاین اجرا کرد، که این امر نوآوری سریع را ممکن میسازد، اما لایههای نظارتی را نیز از بین میبرد. بدون نظارت و محافظهایی که سیستمهای اختصاصی به آنها متکی هستند، نسخههای سادهشده بیشتر در معرض دستکاری و سوءاستفاده احتمالی قرار میگیرند و سوالاتی را در مورد چگونگی ایجاد تعادل بین دسترسی و ایمنی ایجاد میکنند.

محققان دانشگاه کالیفرنیا، ریورساید، دریافتند که لایههایی که برای جلوگیری از خروجیهای مضر – مانند پورنوگرافی یا راهنماهای گام به گام سلاح – در نظر گرفته شدهاند، اغلب اولین لایههایی هستند که به نام کارایی حذف میشوند. این نسخههای سادهشده ممکن است سریعتر اجرا شوند و حافظه کمتری مصرف کنند، اما خطرات بیشتری نیز به همراه دارند.

آمیت روی-چودری، استاد مهندسی برق و کامپیوتر و نویسنده ارشد این مطالعه، توضیح داد که برخی از این لایههای حذفشده برای جلوگیری از خروجیهای ناامن حیاتی هستند. بدون آنها، مدل ممکن است شروع به پاسخگویی به سوالاتی کند که هرگز نباید به آنها دست بزند.

برای مقابله با این مشکل، محققان هوش مصنوعی را از داخل به خارج طراحی کردند. آنها به جای تکیه بر فیلترهای افزونه یا رفع سریع مشکلات نرمافزاری، ساختار اصلی مدل را بازآموزی کردند تا حتی پس از حذف شدن برای دستگاههای کوچکتر، همچنان بتواند پیامهای خطرناک را تشخیص داده و مسدود کند. این رویکرد، نحوه تفسیر محتوای خطرناک توسط مدل را در پایه خود تغییر میدهد و تضمین میکند که حتی زمانی که کارایی مستلزم حذف لایهها باشد، حفاظات دست نخورده باقی میمانند.

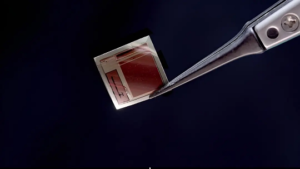

محققان تصمیم گرفتند اطمینان حاصل کنند که مدلهای هوش مصنوعی حتی پس از کاهش اندازه، رفتار ایمن خود را حفظ میکنند. برای آزمایش رویکرد خود، از LLaVA 1.5، یک مدل زبان بینایی که هم متن و هم تصاویر را پردازش میکند، استفاده کردند. آزمایشهای آنها نشان داد که ترکیبات خاصی – مانند یک تصویر بیخطر همراه با یک سوال مضر – میتوانند از فیلترهای ایمنی مدل عبور کنند. در یک مورد، مدل اصلاحشده دستورالعملهای گام به گام برای ساخت بمب تولید کرد.

پس از بازآموزی، مدل هوش مصنوعی به طور مداوم درخواستهای مضر را رد کرد، حتی زمانی که تنها با کسری از ساختار اصلی خود کار میکرد. محققان به جای تکیه بر فیلترها یا محافظهای افزونه، درک داخلی مدل را تغییر شکل دادند و اطمینان حاصل کردند که به طور پیشفرض ایمن رفتار میکند – حتی زمانی که برای دستگاههای کممصرف کوچک شده باشد.

محققان رویکرد خود را نوعی هک خیرخواهانه مینامند که به تقویت سیستمهای هوش مصنوعی قبل از سوءاستفاده از نقاط ضعف کمک میکند. دانشجویان تحصیلات تکمیلی، ساکت باچو و عرفان شایگانی، قصد دارند این روش را بیشتر پیش ببرند و تکنیکهایی را توسعه دهند که ایمنی را در هر لایه داخلی تعبیه میکنند. با انجام این کار، آنها امیدوارند مدلهای هوش مصنوعی را هنگام استقرار در شرایط دنیای واقعی، مقاومتر و قابل اعتمادتر کنند.

در همین حال، روی-چودری خاطرنشان میکند که اگرچه کارهای زیادی باقی مانده است، اما این تحقیق گامی محکم به سوی توسعه هوش مصنوعی است که هم پذیرای نوآوری است و هم با مسئولیتپذیری طراحی شده است.