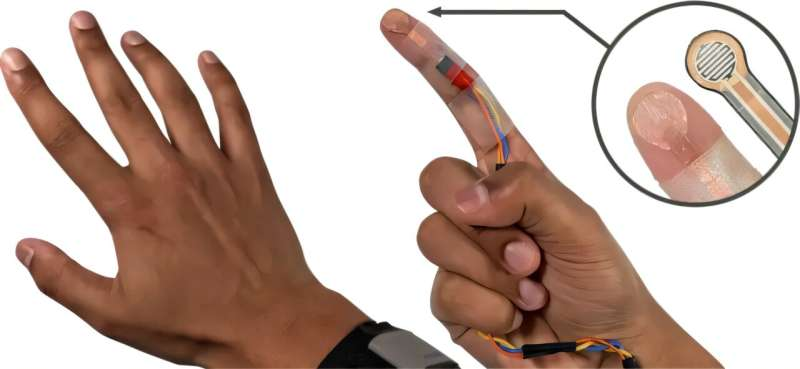

13 نوامبر 2024 -توسط شارلوت هو، دانشگاه کارنگی ملون -محققان از یک حسگر لمسی سفارشی استفاده کردند که در امتداد زیر انگشت اشاره و کف دست قرار داشت تا اطلاعات مربوط به انواع لمس را با نیروهای مختلف جمعآوری کند و در عین حال برای دوربین نامرئی بماند. اعتبار: دانشگاه کارنگی ملون

مقاله ای منتشر شده در مجموعه مقالات سی و هفتمین سمپوزیوم سالانه ACM در زمینه نرم افزار و فناوری رابط کاربری، توسط محققان موسسه تعامل انسان و کامپیوتر دانشگاه کارنگی ملون، EgoTouch را معرفی می کند، ابزاری که از هوش مصنوعی برای کنترل رابط های AR/VR با لمس پوست یک انگشت استفاده می کند.

این تیم می خواست در نهایت کنترلی طراحی کند که بازخورد لمسی را تنها با استفاده از حسگرهایی که با یک هدست استاندارد AR/VR ارائه می شود، ارائه دهد.

OmniTouch، روش قبلی که توسط کریس هریسون، دانشیار HCII و مدیر گروه Future Interfaces ساخته شده بود، نزدیک شد. اما این روش نیاز به یک دوربین خاص، ضخیم و حسگر عمق داشت. ویمال مولین، دانشجوی دکتری که توسط هریسون توصیه شده بود، این ایده را داشت که از یک الگوریتم یادگیری ماشینی برای آموزش دوربین های معمولی برای تشخیص لمس کردن استفاده کند.

مولین گفت: “سعی کنید انگشت خود را بردارید و ببینید وقتی پوست خود را با آن لمس می کنید چه اتفاقی می افتد. متوجه خواهید شد که این سایه ها و تغییر شکل های موضعی پوست وجود دارد که فقط در هنگام لمس پوست رخ می دهد.” اگر بتوانیم اینها را ببینیم، میتوانیم یک مدل یادگیری ماشینی را برای انجام همین کار آموزش دهیم، و اساساً این همان کاری است که ما انجام دادیم.»

مولین داده ها را برای EgoTouch با استفاده از یک حسگر لمسی سفارشی که در امتداد زیر انگشت اشاره و کف دست قرار داشت جمع آوری کرد. این سنسور دادهها را در مورد انواع لمس با نیروهای مختلف جمعآوری میکند در حالی که برای دوربین نامرئی میماند. سپس مدل یاد گرفت که ویژگیهای بصری سایهها و ناهنجاریهای پوست را با لمس و فشار بدون حاشیهنویسی انسانی مرتبط کند.

این تیم مجموعه داده های آموزشی خود را گسترش داد و شامل 15 کاربر با رنگ پوست و تراکم موی مختلف شد و ساعت ها اطلاعات را در بسیاری از موقعیت ها، فعالیت ها و شرایط نوری جمع آوری کرد.

EgoTouch می تواند لمس را با دقت بیش از 96٪ تشخیص دهد و دارای نرخ مثبت کاذب در حدود 5٪ است. فشار دادن به پایین، بلند کردن و کشیدن را تشخیص می دهد. این مدل همچنین میتواند سبک یا سخت بودن لمس را با دقت 98 درصد طبقهبندی کند.

مولین میگوید: «این میتواند برای داشتن قابلیت کلیک راست روی پوست واقعا مفید باشد.

تشخیص تغییرات در تماس می تواند توسعه دهندگان را قادر می سازد تا حرکات صفحه لمسی روی پوست را تقلید کنند. به عنوان مثال، یک گوشی هوشمند می تواند اسکرول کردن صفحه به بالا یا پایین، بزرگنمایی، کشیدن انگشت به سمت راست، یا فشار دادن و نگه داشتن یک نماد را تشخیص دهد. برای ترجمه این به یک رابط مبتنی بر پوست، دوربین باید تفاوتهای ظریف بین نوع لمس و نیروی لمس را تشخیص دهد.

دقت در رنگ های مختلف پوست و تراکم مو، و در نواحی مختلف دست و ساعد مانند جلوی بازو، پشت بازو، کف دست و پشت دست تقریباً یکسان بود. این سیستم در نواحی استخوانی مانند بند انگشتان عملکرد خوبی نداشت.

مولین گفت: «احتمالاً به این دلیل است که تغییر شکل پوست در آن نواحی زیاد نبوده است. “به عنوان یک طراح رابط کاربری، کاری که می توانید انجام دهید این است که از قرار دادن عناصر در آن مناطق اجتناب کنید.”

Mollyn در حال بررسی راههایی برای استفاده از دوربینهای دید در شب و روشنایی در شب برای فعال کردن سیستم EgoTouch در تاریکی است. او همچنین با محققان برای گسترش این روش تشخیص لمسی به سطوحی غیر از پوست همکاری می کند.

مولین گفت: “برای اولین بار، ما سیستمی داریم که فقط از دوربینی استفاده می کند که از قبل در همه هدست ها وجود دارد. مدل های ما بدون کالیبراسیون هستند و کاملاً خارج از جعبه کار می کنند.” اکنون میتوانیم کارهای قبلی را روی رابطهای روی پوست انجام دهیم و در واقع آنها را واقعی کنیم.»