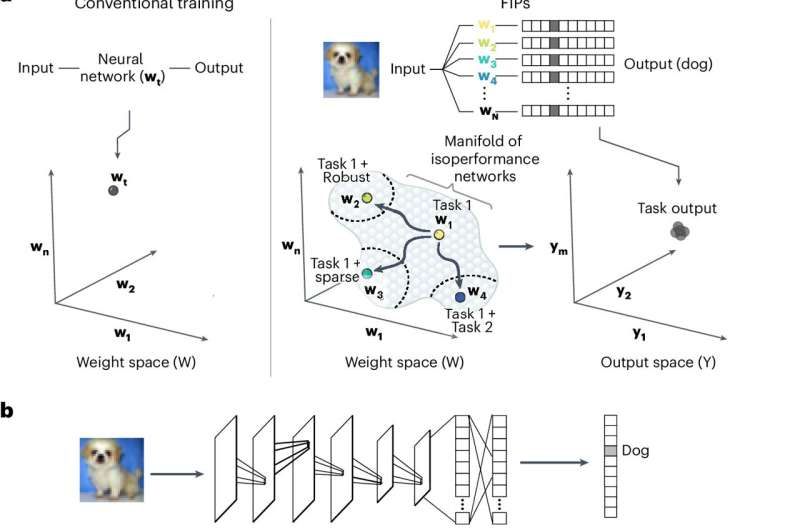

9 اکتبر 2024 -توسط موسسه فناوری کالیفرنیا -چارچوب هندسی دیفرانسیل برای ساخت FIP در فضای وزنی الف، سمت چپ: آموزش معمولی روی یک کار، یک راه حل شبکه آموزش دیده (wt) را پیدا می کند. درست: استراتژی FIP یک زیرمنیفولد از شبکههای عملکردی (w1, w2…wN) را برای یک کار مورد علاقه کشف میکند که امکان جستجوی کارآمد برای شبکههای دارای استحکام دشمن (w2)، شبکههای پراکنده با عملکرد بالا (w3) و برای یادگیری را فراهم میکند. چندین کار بدون فراموشی (w4). b، Top: یک CNN آموزش دیده با پیکربندی وزن (wt)، که با خطوطی که لایههای مختلف شبکه را به هم متصل میکنند، نمایش داده میشود، یک تصویر ورودی x را میپذیرد و یک بردار خروجی ده عنصری، f(x، wt) تولید میکند. پایین: اغتشاش وزن شبکه توسط dw منجر به ایجاد یک شبکه جدید با پیکربندی وزن wt + dw با بردار خروجی تغییر یافته، fx، wt + dw، برای همان ورودی، x می شود. ج، الگوریتم FIP اغتشاشات وزن θ* را شناسایی میکند که فاصله حرکتشده در فضای خروجی را به حداقل میرساند و همترازی را با گرادیان تابع هدف ثانویه (∇wL) به حداکثر میرساند. پیکان آبی روشن یک اختلال وزن ϵ-هنجار را نشان می دهد که فاصله جابجا شده در فضای خروجی را به حداقل می رساند و فلش آبی تیره نشان دهنده اختلال وزن ϵ-نرمی است که همسویی با گرادیان تابع هدف، L(x, w) را به حداکثر می رساند. تابع هدف ثانویه L(x, w) برای حل چالشهای متمایز یادگیری ماشین متفاوت است. d، الگوریتم نمونهبرداری مسیر، FIPها، γ(t) را از طریق شناسایی تکراری اختلالات ε-هنجار (θ*(t)) در فضای وزن تعریف میکند. اعتبار: هوش ماشین طبیعت (2024). DOI-x

شبکه های عصبی توانایی قابل توجهی در یادگیری وظایف خاص مانند شناسایی ارقام دست نویس دارند. با این حال، این مدلها اغلب هنگام آموزش وظایف اضافی، «فراموشی فاجعهبار» را تجربه میکنند: آنها میتوانند تکالیف جدید را با موفقیت یاد بگیرند، اما «فراموش میکنند» که چگونه تکالیف اصلی را تکمیل کنند. برای بسیاری از شبکههای عصبی مصنوعی، مانند شبکههایی که ماشینهای خودران را هدایت میکنند، یادگیری وظایف اضافی به برنامهریزی کامل نیاز دارد.

از سوی دیگر، مغزهای بیولوژیکی به طور قابل توجهی انعطاف پذیر هستند. به عنوان مثال، انسان ها و حیوانات می توانند به راحتی یاد بگیرند که چگونه یک بازی جدید را انجام دهند، بدون اینکه نیازی به یادگیری دوباره راه رفتن و صحبت کردن باشند.

با الهام از انعطافپذیری مغز انسان و حیوان، محققان Caltech اکنون نوع جدیدی از الگوریتم را توسعه دادهاند که شبکههای عصبی را قادر میسازد تا بهطور مداوم با دادههای جدیدی که میتوانند از آنها بیاموزند بدون نیاز به شروع از صفر بهروزرسانی شوند. این الگوریتم که الگوریتم مسیر ثابت عملکردی (FIP) نامیده میشود، کاربردهای گستردهای از بهبود توصیهها در فروشگاههای آنلاین تا تنظیم دقیق خودروهای خودران دارد.

این الگوریتم در آزمایشگاه مت تامسون، استادیار زیست شناسی محاسباتی و محقق موسسه تحقیقات پزشکی میراث (HMRI) توسعه داده شد. این تحقیق در مطالعه جدیدی که در مجله Nature Machine Intelligence منتشر شده است، توضیح داده شده است.

تامسون و دانشجوی فارغ التحصیل Ph.D. از تحقیقات علوم اعصاب در Caltech، به ویژه در آزمایشگاه کارلوس لوئیس، پروفسور محقق زیست شناسی الهام گرفته شدند. لوئیس مطالعه می کند که چگونه پرندگان می توانند مغز خود را مجدداً سیم کشی کنند تا یاد بگیرند که چگونه دوباره پس از آسیب مغزی آواز بخوانند. انسان ها نیز می توانند این کار را انجام دهند. به عنوان مثال، افرادی که آسیب مغزی ناشی از سکته مغزی را تجربه کرده اند، اغلب می توانند اتصالات عصبی جدیدی ایجاد کنند تا عملکردهای روزمره را دوباره یاد بگیرند.

تامسون میگوید: «این یک پروژه سالها بود که با علم پایه درباره نحوه یادگیری انعطافپذیر مغزها آغاز شد. چگونه این قابلیت را به شبکه های عصبی مصنوعی بدهیم؟

این تیم الگوریتم FIP را با استفاده از یک تکنیک ریاضی به نام هندسه دیفرانسیل توسعه دادند. این چارچوب اجازه می دهد تا یک شبکه عصبی بدون از دست دادن اطلاعات رمزگذاری شده قبلی اصلاح شود.

در سال 2022، با راهنمایی جولی شوئنفلد، کارآفرین Caltech In Residence، Raghavan و Thomson شرکتی به نام Yurts را برای توسعه بیشتر الگوریتم FIP و استقرار سیستم های یادگیری ماشین در مقیاس برای رفع بسیاری از مشکلات مختلف راه اندازی کردند. راغوان یورتز را با متخصصان صنعت بن ون رو و جیسون شنیتزر بنیان گذاشت.