16 سپتامبر 2024 – توسط نیک پاپاژورجیو، دانشکده پلی تکنیک فدرال لوزان

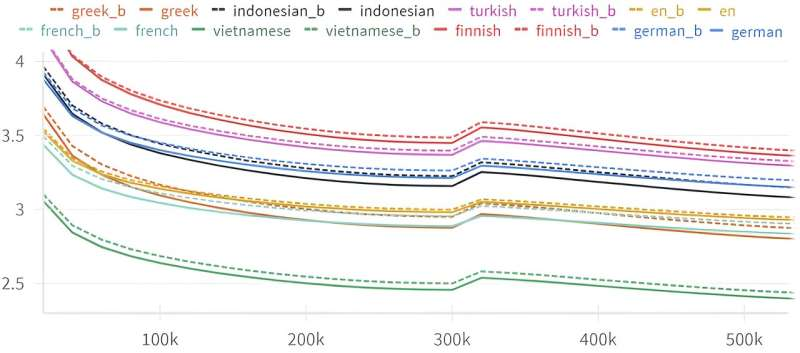

منحنیهای تلفات اعتبارسنجی برای مدلهای FW و BW در طول آموزش به طور مداوم، تلفات BW بیشتر از همتای FW خود است. این از طریق شروع مجدد گرم نرخ یادگیری ادامه می یابد، که باعث از دست دادن ضربه می شود. اعتبار: arXiv (2024). DOI: 10.48550/arxiv.2401.17505

محققان دریافتهاند که مدلهای زبان بزرگ هوش مصنوعی، مانند GPT-4، در پیشبینی چیزهای بعدی بهتر از آنچه در یک جمله آمده است، هستند. این اثر «پیکان زمان» میتواند درک ما از ساختار زبان طبیعی و نحوه درک این مدلها از آن را تغییر دهد.

مدل های زبان بزرگ (LLM) مانند GPT-4 برای کارهایی مانند تولید متن، کدنویسی، عملیات چت بات ها، ترجمه و موارد دیگر ضروری شده اند. در قلب آنها، LLM ها با پیش بینی کلمه بعدی در یک جمله بر اساس کلمات قبلی کار می کنند – یک ایده ساده اما قدرتمند که بسیاری از عملکرد آنها را هدایت می کند.

اما چه اتفاقی میافتد وقتی از این مدلها میخواهیم عقبنشینی را پیشبینی کنند – «در زمان به عقب بروند» و کلمه قبلی را از مدلهای بعدی تعیین کنند؟

این سوال باعث شد که پروفسور کلمان هونگلر در EPFL و ژرمی ونگر از گلداسمیتز (لندن) به بررسی این موضوع بپردازند که آیا LLM ها می توانند داستانی را به عقب بسازند و از آخر شروع کنند. آنها با همکاری با واسیلیس پاپادوپولوس، محقق یادگیری ماشین در EPFL، چیز شگفتانگیزی را کشف کردند: LLMها به طور مداوم هنگام پیشبینی عقبنشینی نسبت به جلو، دقت کمتری دارند.

محققان LLM ها را با معماری ها و اندازه های مختلف، از جمله ترانسفورماتورهای از پیش آموزش دیده (GPT)، واحدهای بازگشتی دردار (GRU) و شبکه های عصبی حافظه کوتاه مدت (LSTM) آزمایش کردند. هر یک از آنها سوگیری “پیکان زمان” را نشان دادند و عدم تقارن اساسی را در نحوه پردازش متن LLM آشکار کرد.

هونگلر توضیح می دهد: “این کشف نشان می دهد که اگرچه LLM ها هم در پیش بینی کلمه بعدی و هم در پیش بینی کلمه قبلی در یک متن بسیار خوب هستند، اما همیشه کمی بدتر از جلو هستند: عملکرد آنها در پیش بینی کلمه قبلی همیشه چند درصد بدتر است. این پدیده در بین زبان ها جهانی است و با هر مدل زبانی بزرگ قابل مشاهده است.

این کار همچنین با کار کلود شانون، پدر نظریه اطلاعات، در مقاله مهم خود در سال 1951 مرتبط است. شانون بررسی کرد که آیا پیشبینی حرف بعدی در یک دنباله به آسانی پیشبینی حرف قبلی است یا خیر. او کشف کرد که اگرچه هر دو کار از نظر تئوری باید به یک اندازه دشوار باشند، اما پیشبینی عقبنشینی برای انسانها چالشبرانگیزتر بود – اگرچه تفاوت عملکرد حداقل بود.

هونگلر میگوید: «در تئوری، نباید تفاوتی بین جهتهای رو به جلو و عقب وجود داشته باشد، اما به نظر میرسد LLMها به نوعی به جهت زمانی که متن را در آن پردازش میکنند، حساس هستند. جالب اینجاست که این به ویژگی عمیق ساختار زبان مربوط می شود که تنها با ظهور مدل های زبانی بزرگ در پنج سال گذشته کشف شد.

محققان این ویژگی را به حضور عوامل هوشمند پردازش اطلاعات مرتبط میدانند، به این معنی که میتوان از آن به عنوان ابزاری برای تشخیص هوش یا زندگی استفاده کرد و به طراحی LLMهای قدرتمندتر کمک کرد. در نهایت، می تواند مسیرهای جدیدی را برای تلاش طولانی مدت برای درک گذر زمان به عنوان یک پدیده نوظهور در فیزیک نشان دهد.

کار بر روی سرور preprint arXiv منتشر شده است.

این مطالعه به خودی خود پیشینه جالبی دارد که هونگلر به آن اشاره می کند. در سال 2020، با ژرمی [ونگر]، با مدرسه تئاتر The Manufacture همکاری میکردیم تا یک ربات چت بسازیم که در کنار بازیگران برای انجام کارهای بداهه بازی کند؛ در بداهه، اغلب میخواهید داستان را ادامه دهید، در حالی که میدانید پایان باید چگونه باشد.

برای ساختن داستانهایی که به شیوهای خاص به پایان میرسند، ما این ایده را به ذهنمان رساندیم که چت بات را آموزش دهیم تا «به عقب» صحبت کند، به آن اجازه میدهیم با توجه به پایانش داستانی تولید کند – به عنوان مثال، اگر پایان این باشد که «آنها تا به حال با خوشحالی زندگی کردهاند». ,’ مدل می تواند به شما بگوید که چگونه اتفاق افتاده است، بنابراین، ما به مدل ها آموزش دادیم تا این کار را انجام دهند و متوجه شدیم که کمی عقب تر از جلو هستند.

«با واسیلیس [پاپادوپولوس] بعداً متوجه شدیم که این یک ویژگی عمیق زبان است و این یک پدیده کاملاً جدید است که پیوندهای عمیقی با گذشت زمان، هوش و مفهوم علیت دارد..”

هیجان هونگلر از این اثر تا حد زیادی ناشی از غافلگیری غیرمنتظره ای است که در این راه پیش آمد. فقط زمان می تواند بگوید که کاری که به عنوان یک پروژه تئاتر شروع شد، در نهایت ابزارهای جدیدی برای درک چیزهای زیادی در مورد جهان به ما می دهد.»