18 مه 2022 -توسط دانشگاه لیهای -اعتبار: CC0 دامنه عمومی

داده ها بر روی یک مدل ریاضی مانند دانه های شن و ماسه که در یک منظره سنگی پرتاب می شوند،برخی از این دانهها به سادگی همراه با ضربه کم یا بدون ضربه حرکت میکنند. اما برخی از آنها نشان خود را می گذارند: آزمایش، سخت شدن و در نهایت تغییر شکل چشم انداز مطابق با الگوهای ذاتی و نوساناتی که در طول زمان ظاهر می شوند.

ریک بلوم، پروفسور رابرت دبلیو. ویزمن، استاد مهندسی برق و کامپیوتر در دانشگاه لیهای، به دنبال کارآمدی تکنیکهای یادگیری توزیعشده است که برای هوش مصنوعی مدرن (AI) و یادگیری ماشینی (ML) حیاتی هستند. در اصل، هدف او پرتاب دانه های بسیار کمتری از داده ها بدون کاهش تأثیر کلی است.

در مقاله «یادگیری توزیع شده با تفاوتهای گرادیان پراکنده»، منتشر شده در یک شماره ویژه متمرکز بر ML در مجله IEEE Selected Topics in Signal Processing، Blum و همکارانش استفاده از «روش نزول گرادیان با اسپاسفیکاسیون و تصحیح خطا» را پیشنهاد کردند. GD-SEC، برای بهبود کارایی ارتباطات یادگیری ماشینی انجام شده در 17 می 2022 منتشر شد.

او میگوید: مشکلات در بهینهسازی توزیعشده در سناریوهای مختلفی ظاهر میشوند که معمولاً به ارتباطات بیسیم متکی هستند. تأخیر، مقیاس پذیری و حریم خصوصی چالش های اساسی هستند.

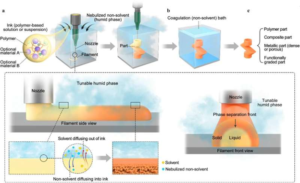

او ادامه میدهد: «الگوریتمهای مختلف بهینهسازی توزیعشده برای حل این مشکل ایجاد شدهاند.» و یکی از روشهای اصلی استفاده از GD کلاسیک در معماری کاربر-سرور است. در این محیط، سرور مرکزی پس از تجمیع دادههای دریافتی از پارامترهای مدل را بهروزرسانی میکند. همه کاربران، و سپس پارامترهای به روز شده را برای کاربران پخش می کند. اما عملکرد کلی با این واقعیت محدود می شود که هر کاربر باید تمام داده های خود را همیشه منتقل کند. هنگام آموزش یک شبکه عصبی عمیق، این می تواند طبق دستور باشد. 200 مگابایت از هر دستگاه کاربر در هر تکرار. این مرحله ارتباطی می تواند به راحتی به یک گلوگاه مهم در عملکرد کلی تبدیل شود، به ویژه در سیستم های یادگیری جمعی و هوش مصنوعی لبه.”

بلوم توضیح می دهد که از طریق استفاده از GD-SEC، الزامات ارتباطی به میزان قابل توجهی کاهش می یابد. این تکنیک از یک رویکرد فشردهسازی داده استفاده میکند که در آن هر کاربر مولفههای گرادیان بزرگی کوچک را صفر میکند – معادل پردازش سیگنال عدم تعریق چیزهای کوچک. سپس کاربر فقط اجزای غیر صفر باقی مانده را به سرور منتقل می کند. به عبارت دیگر، داده های معنی دار و قابل استفاده تنها بسته هایی هستند که در مدل راه اندازی می شوند.

بلوم میگوید: «روشهای فعلی موقعیتی را ایجاد میکنند که در آن هر کاربر هزینه محاسباتی گرانی دارد؛ GD-SEC نسبتاً ارزان است که در هر دور فقط یک مرحله GD مورد نیاز است.

همکاران پروفسور بلوم در این پروژه عبارتند از دانشجوی سابق وی، ییچنگ چن، دکترا، که اکنون یک مهندس نرم افزار در لینکدین است. مارتین تاکاچ، دانشیار دانشگاه هوش مصنوعی محمد بن زاید؛ و برایان ام. سادلر، همکار IEEE، دانشمند ارشد ارتش ایالات متحده برای سیستم های هوشمند، و عضو آزمایشگاه تحقیقاتی ارتش.