8 اکتبر 2020توسط بن پل ، دانشگاه جنوب کالیفرنیااعتبار: دامنه عمومی Pixabay / CC0

ماه گذشته ، سوفی ویلمس ، نخست وزیر بلژیک ، در یک ویدیوی آنلاین ظاهر شد و به مخاطبان خود گفت که بیماری همه گیر COVID-19 با “بهره برداری و تخریب توسط انسانها از محیط طبیعی ما” مرتبط است. این دو بحران وجودی به هم مرتبط باشند یا نباشند ، واقعیت این است که ویلمس چنین چیزی نگفت. این ویدیو که توسط سازمانی از فعالان تغییر اقلیم تولید شده است ، در واقع یک جعل عمیق یا نوعی رسانه جعلی بود که با استفاده از یادگیری عمیق ایجاد شده است. جعل عمیق یکی دیگر از راه های انتشار اطلاعات نادرست است – گویا از قبل اخبار جعلی ، خود همه گیری همه کافی نبوده است.

از آنجا که اقدامات امنیتی جدید به طور مداوم بسیاری از تصاویر و فیلم های جعلی عمیق را ضبط می کند ، ممکن است مردم به یک احساس کاذب امنیتی دچار شوند که ما شرایط را تحت کنترل داریم. متأسفانه ، تا آنجا که ما میدانیم این ممکن است دور از واقعیت باشد . پروفسور بارت كوسكو در بخش مهندسی برق و رایانه مینگ هسیه گفت: “تولید Deepfakes با قدرتمندتر شدن رایانه ها و تشخیص آن دشوارتر می شود و سخت تر می شود. الگوریتم های یادگیری بسیار پیچیده تر می شوند.

در مقاله ای که اخیراً از دوره یادگیری عصبی و هوش محاسباتی پروفسور کاسکو نشات گرفته است ، دانشجویان کارشناسی ارشد مهندسی برق و کامپیوتر Apurva Gandhi و Shomik Jain نشان دادند که چگونه تصاویر عمیق و کاذب می توانند حتی پیچیده ترین آشکارسازها را با کمی اختلاف تغییر دهند. تحقیقات همزمان از Google Brain و روشهای گسترده ای را برای ایجاد این تغییرات ذکر کرد. یک تیم در دانشگاه کالیفرنیا سان دیگو نیز در مورد فیلم های جعلی عمیق به نتایج مشابهی رسیده اند.

آشکارسازهای مدرن امروزی بر اساس شبکه های عصبی کانولوشن ساخته شده اند. در حالی که در ابتدا ، این مدل ها بسیار دقیق به نظر می رسند ، اما یک نقص عمده را ارایه می کنند. گاندی و جین نشان دادند که این آشکارسازهای عمیق در برابر اغتشاشات مخالف، آسیب پذیر هستند که تغییراتی کوچک و انتخاب شده از نظر استراتژیک فقط در چند مقدار پیکسل در تصویر هستند.

گاندی گفت: “اگر deepfake یک ویروس باشد بنابر این آشکارساز deepfake یک واکسن است ، پس می توانید اغتشاشات خصمانه را به عنوان یک جهش تصور کنید.” “دقیقاً مانند یک جهش بسیار کوچک ویروس که ممکن است واکسن را بی فایده کند ، اغتشاشات ریز تصویر نیز می تواند همین کار را در آشکارسازهای عمیق جعلی پیشرفته انجام دهد.”

نتایج مقاله آنها نشان می دهد که سیستم های امنیتی کنونی ما چه نقصی دارند. شبکه های عصبی که این دو آموزش دیده اند در ابتدا بیش از 95٪ از عمیق ساختهای روزمره را شناسایی کرده اند. اما هنگامی که تصاویر را آشفته می کردند ، آشکارسازها قادر به بدست آوردن (بررسی یادداشت ها) صفر درصد بودند. بله ، درست خواندید. در شرایط مناسب ، این روش اساساً کل دستگاه امنیتی عمیق ما را از رده خارج می کند. با یک انتخاب در گوشه و یک بیماری همه گیر که ثبات جهانی را تهدید می کند ، نمی توان نتیجه آن را نادیده گرفت.

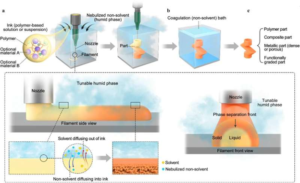

البته هدف هر مهندس خوب ارائه راه حل است ، نه فقط اشاره به نقص. و گام بعدی برای گاندی و جین انجام این کار است. اولین ایده آنها ایجاد شبکه های عصبی در برابر اغتشاشات خصمانه است. این کار توسط چیزی به نام قاعده مند سازی انجام می شود ، استراتژی که ثبات شبکه عصبی را در حالی که هنوز تحت آموزش است بهبود می بخشد. این روش ، تشخیص عمیق تقلبی آشفته را 10٪ بهبود بخشید که دلگرم کننده است اما تغییر دهنده بازی نیست.

با این حال ، استراتژی امیدوار کننده تر آنها چیزی است به نام تصویر عمیق دفاع قبلی. اساساً این فرایند سعی دارد قبل از تغذیه آشکارسازها ، این آشفتگی های کاذب را از روی تصاویر حذف کند. برای توسعه این تکنیک ، دو الگوریتم خلاقانه با هدف ایجاد کیفیت تصویر در ابتدا نوشته شده اند. در حالی که تصویر عمیق دفاع عمیق ، عمق جعلی آشفته را با دقت 95٪ مشخص کرده است ، الگوریتم بسیار کند است. پردازش فقط یک تصویر می تواند 20-30 دقیقه طول بکشد. جین گفت: “یک چالش اساسی یافتن روشهای کارآمدتر ، به طور بالقوه بدون شبکه های عصبی ، برای بهبود آشکارسازهای ساختگی عمیق به گونه ای است که آنها در برابر اغتشاشات خصمانه ایمن باشند.” “سپس این تکنیک ها می توانند ردیاب های آسیب پذیر را در سیستم عامل هایی مانند رسانه های اجتماعی بهبود بخشند.”